На этом этапе большие группы неправильных кадров должны быть удалены, чтобы не тратить на них вычислительные ресурсы. Ложные кадры — это все кадры, в которых нет четко различимого лица. Лицо не должно быть закрыто каким-либо предметом, волосами и т.д. Не тратьте время на малые группы. Мы удалим их на следующем этапе.

Deepfake: краткая история появления и нюансы работы технологии

Мы уже писали об имитациях. Технология производства такого контента сегодня достигла очень высокого уровня. Правда, даже очень хорошо подготовленные подделки можно (все еще) отличить с помощью специальных технологий. Совсем недавно дипфейки делали ради забавы или чтобы досадить кому-то, но теперь их начинают использовать в интересах различных бизнесов — телевидения, кино и т.д. — используются. Актерам даже больше не нужно лично выражать своих героев в кино или мультфильмах — технология позволяет синтезировать все слова и фразы, которые должен был произнести актер (тон голоса, высота голоса и т.д. синтезируются с большой точностью).

Однако есть и другая сторона медали. Помимо индустрии развлечений, дипфейки также используются для создания поддельных видеозаписей известных людей. Это могут быть одни и те же актеры, политики, бизнесмены — кто угодно. Сочетание технологий искусственного интеллекта и CGI приводит к поистине чудесным результатам и далеко идущим возможностям, которые могут быть использованы как в благих, так и в недобрых целях. Как все это работает?

Немного истории

Технологии синтеза видео и аудио не новы. Он находится в разработке с конца 1990-х годов. Конечно, и до этого предпринимались различные усилия, но мы говорим о технологиях, которые развивались. Например, компания Video Rewrite в 1997 году представила технологию, позволяющую создавать видео, в котором выражения лиц соответствуют синтезированному саундтреку. То есть, симулированные выражения лица были смоделированы так, чтобы соответствовать синтезированному компьютером саундтреку.

Однако это были лишь начальные усилия, активно развивавшиеся в течение двух десятилетий. Теперь у нас есть доступ к технологии обработки речи, сочетающей компьютерную графику с реальным видео и многое другое. Искусственный интеллект используется не везде, но наиболее реалистичные системы разработаны с использованием машинного обучения.

Долгое время эти технологии были известны лишь ограниченному кругу специалистов. Однако в 2009 году на рынок вышел фильм «Аватар», который стал довольно убедительной демонстрацией подобных технологий. В 2014 году молодая Одри Хепберн снялась в рекламе шоколада — ее лицо было отображено на лице актрисы с помощью специального программного обеспечения. В 2019 году вышел фильм «Ирландец», в котором лица актеров были в значительной степени воскрешены с помощью искусственного интеллекта. Для создания мимики персонажей использовался искусственный интеллект, который был создан с помощью искусственного интеллекта.

Почему Deepfake? Технология получила свое название в 2017 году. Пользователь Reddit создал несколько не очень приличных видеороликов с лицами знаменитостей. Ник пользователя был Deepfake, и поэтому было решено использовать это слово для обозначения подобных технологий. И надо сказать, что эти технологии стали развиваться очень активно.

Появление «настоящих» дипфейков

За относительно короткое время появилось множество компаний, предлагающих решения для синтетического производства видео и аудио — не только людей, но и целых сцен. YouTube-каналы с Deepfakes, такие как Shamrock и Ctrl Shift Face, набрали большое количество подписчиков. Простые в использовании приложения для глубокой подделки — обычное дело. Индустрия развлечений создает совершенно искусственные персонажи, которые становятся знаменитыми. Примером может служить Lil Michela или Michela Souza.

Нет сомнений, что со временем будет появляться все больше и больше реалистичных подделок. Уже сейчас они никого не удивляют, а в ближайшем будущем станут обычным явлением. Но кто отвечает за разработку технологии, где она используется, как она работает и чего мы можем ожидать в будущем?

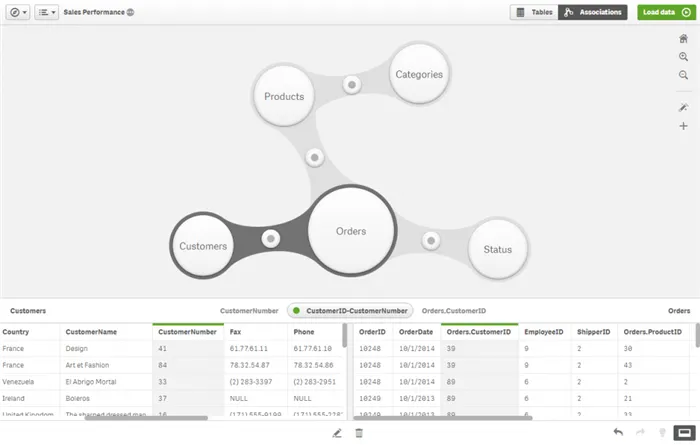

По словам Калугина, для создания дипшейк видео можно использовать развлекательные приложения, такие как RefaceAI (более 100 миллионов загрузок в Google Store) или более продвинутые программы с заранее созданными библиотеками, такие как DeepFaceLab и SimSwap. SimSwap, по словам эксперта, требует минимальных технических знаний, имеет низкие требования к производительности системы и поставляется с предварительно обученной моделью, которая позволяет создавать видеоролики с дипшейком на основе одной фотографии.

В наши дни для создания фейка не нужно особенно разбираться в инструментах редактирования видео, соглашается Владислав Тушканов, старший научный сотрудник «Лаборатории Касперского». С другой стороны, он считает, что самые известные дипшейки, такие как «альтернативный салют» британской королевы или дипшейк с Томом Крузом, играющим в гольф, были сделаны профессионалами в области видеоэффектов, а в последнем случае с помощью профессионального актера, похожего на него.

Легко ли сделать дипфейк

Между тем, существуют автоматические системы, способные обнаруживать землетрясения. Одна из таких систем была разработана в Университете Буффало; она обнаруживает имитацию по ложному отражению в глазах.

В целом, выявить мошеннические видеоролики несложно. Как в случае с «поддельным» Тиньковым: лицо на видео легко отличить от настоящего при ближайшем рассмотрении, слышен другой голос, качество видео низкое и оно распространяется в социальных сетях — то есть предназначено для просмотра на маленьких экранах мобильных устройств, говорит Тушканов. На это и рассчитывают мошенники: в потоке социальной сети, даже если она лишь приблизительно похожа

Как распознать дипфейк

Плохая новость заключается в том, что существует своего рода гонка между исследователями, разрабатывающими алгоритмы подделок, и теми, кто ищет способы их обнаружения: Когда обнаруживается недостаток dipfake, разрабатывается основанный на нем метод обнаружения, но следующее поколение алгоритмов создания уже учится обходить его, говорит Тушканов.

По словам Тушканова, самым важным средством против злоумышленников, использующих псевдонимы в злонамеренных целях, является информирование пользователей об этом явлении и основных правилах кибербезопасности.

Следует критически относиться к чрезвычайно щедрым предложениям, только мошенники обещают много денег просто так, продолжает он. Не верьте предложениям, в которых знаменитость предлагает принять участие в беспроигрышной лотерее или выполнить сомнительную деятельность в Интернете. Прежде чем предпринимать какие-либо действия, необходимо проверить информацию на официальном сайте компании или организации, от имени которой предлагается выплата.

- на излишнюю пикселизацию, дефекты, нечеткое и смазанное изображение, дублирование элементов;

- на неестественную мимику, особенно при моргании, движении бровей и губ;

- на низкое качество видео, за которым нередко пытаются скрыть некорректную работу нейросетей;

- на отличия в телосложении, прическе и голосе. Злоумышленники нередко подбирает похожих по типажу актеров, а голос может быть также скорректирован с помощью технологии дипфейк, например, в программах RealTimeVoiceCLoning, Resemble и Descript;

- в наиболее популярных решениях заменяется только лицо, поэтому можно заметить границу замененного лица, различие в тенях, освещенности и оттенке кожи.

Как появилась самая важная новая технология машинного обучения и где она используется

Однажды вечером Ян Гудфеллоу, аспирант Монреальского университета, спорил с друзьями за кружкой пива. Его друзья поделились с ним идеей: Они хотели создать нейронную сеть, которая могла бы распознавать лица людей, которых никогда не существовало. Все прошло не очень хорошо. На получившихся изображениях отсутствовало ухо или нос, или были все детали, но портрет больше напоминал шизоидную аппликацию из вырезанных частей лица со странными пропорциями, чем нормальное лицо. Программисты хотели исправить нездоровый творческий стиль нейросети, заставив ее проанализировать большое количество реальных фотографий. Но Гудфеллоу обманул их. Для этого потребовались бы вычислительные мощности, которых у его друзей просто не было. Поэтому они не смогли бы этого сделать, если бы не…. Если бы они не создали вторую нейронную сеть, которая критиковала бы первую, а затем поставили их друг против друга, заставляя спорить до тех пор, пока они не создадут изображения нужного качества.

Как избежать обмана

На этот раз друзья Гудфеллоу снисходительно улыбались: какие только глупости не приходят в голову в конце вечера в знаменитом монреальском ресторане «Три повара»! И вот мы расстались.

Но вместо того, чтобы лечь спать и забыть о своем пьяном откровении на следующее утро, Ян Гудфеллоу пришел домой и сел за компьютер.

GAN: самоучитель для нейросетей

Вскоре родился алгоритм, который наделил машины даром воображения. Благодаря Deep Learning они уже смогли видеть, слышать и распознавать. Дайте сети несколько изображений, и она научится распознавать на них, например, пешехода, который переходит дорогу. Так появились автопилоты Siri и Alice. Но как же

Изображения и таблицы, созданные искусственным интеллектом с помощью GAN, уже никого не удивляют. Самый известный экземпляр был продан на престижном аукционе Christie’s в Лондоне за 432 500 долларов. В названии «Шедевр» — портрет Эдмона Беллами — угадывается приветствие отцу GAN: французское bel ami означает «хороший друг». Примерно так переводится с английского фамилия Гудфеллоу.

Идея Гудфеллоу помогла заработать не только художникам, но и специалистам по компьютерным спецэффектам. В прошлом для создания фантастической реальности требовались миллионы долларов, 3D-сканированные актеры и огромные компьютерные мощности. Но чтобы изменить лица каскадера и актера, нужен только ноутбук.

GAN может радикально улучшить качество изображения: Нейронная сеть «думает» о недостающих деталях, поэтому мы можем смотреть старые мультфильмы в HD, а врачи могут увидеть все детали на фотографии с плохим разрешением.

Что создатели Deepfakes заставляют знаменитостей делать и говорить — и как это меняет мир

Когда: 2018.

Автор: Пользователи YouTube.

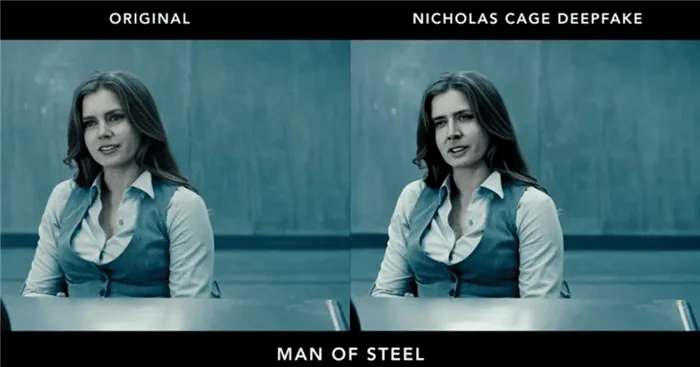

Пример из практики: поклонники дипфейков ставят актера в фильмы, в которых он никогда не снимался. Дон Корлеоне из «Крестного отца», Нео из «Матрицы», Мария из «Звуков музыки». Для Кейджа нет ничего невозможного!

Последствия: Другие актеры также начали появляться в нетипичных ролях. Джим Кэри появился в «Сиянии» и «Джокере», Сильвестр Сталлоне — в «Терминаторе», а Арнольд Шварценеггер перевоплотился во всех персонажей трилогии «Властелин колец». Список можно продолжать.

Фальшивые звёзды

Когда: 2019.

Автор: Политический портал WatchDogs.

Сюжет: Пелоси, спикер Палаты представителей США, произносит речь, но плохо выговаривает слова. Пользователи даже считали, что оппонент президента Дональда Трампа (в то время между ними произошло очное противостояние) был пьян.

Последствия: Пелоси назвала видео «сексистским бредом». По ее просьбе YouTube удалил видео, но несколько копий остались в сети.

Трамп и Обама тоже пострадали: в 2017 году Барак назвал Дональда «глубоким дерьмом» и был «одобрен» режиссером Джорданом Пилом и BuzzFeed.

Когда: 2019.

Автор.

Сюжет: В тизере к вымышленному телепроекту глава Amazon пытается привлечь внимание общественности к горящим лесам в Амазонии. Вымышленный Безос обязательно «заимствует» название лесов для своей компании. Это, по словам двойника миллиардера, позволило ему стать «самым богатым человеком в мире».

Последствия: Видео, как и предыдущие работы, получило некоторую известность

Последствия: Иконописный Дали сопровождал посетителей музея на выставке «Дали живет». Учитель жестикулировал, рисовал, шутил, рассказывал истории, общался со всеми посетителями и делал с ними селфи. Чтобы добиться такого результата, разработчикам потребовалось более 6 000 изображений художника и 1 000 часов машинного обучения.

Когда: 2019.

Автор: некоммерческая организация Change the Ref.

Гипотеза: На видеозаписи, опубликованной в Twitter, изображен мертвый американский подросток, призывающий поддержать политиков, предлагающих контроль над оружием. «Ноябрьские выборы — это первые выборы, на которых я могу голосовать. Но я больше не смогу выбирать, в каком мире я хочу жить. Вот почему вы должны голосовать за меня», — говорит мальчик, погибший в результате массовой стрельбы в средней школе Marjory Stoneman Douglas в феврале 2018 года.