В отношении интернет-данных это означает, что сбор информации, на которую не требуется лицензия, является законным. Однако личные данные пользователей защищены отдельным законом и не могут быть использованы в целях целевой рекламы или кампаний по электронной почте.

Что такое парсинг и как правильно парсить

Современный маркетинг предполагает работу с огромными объемами данных. Вам необходимо проанализировать показатели вашего сайта, ваших конкурентов, вашей аудитории и множество других вещей. Но откуда вы берете эти данные? Вы можете собрать что-то вручную, обратиться к метрике, Wordstat или другому аналитическому сервису и увидеть что-то. Но собирать информацию вручную часто бывает недостаточно, поэтому на помощь приходит аналитика.

Проще говоря, аналитика — это автоматический сбор данных по определенным параметрам или для решения определенных задач. Поэтому аналитики — это специализированные службы для автоматического сбора данных. Они могут собирать информацию практически из любого источника. Там, где вы можете извлекать данные вручную, вы также можете использовать аналитику, при условии, что вы выбрали правильный инструмент для этой работы.

В этой статье мы рассмотрим аналитику, которую вы можете использовать для сбора полезных данных для развития вашего сайта.

Законно ли использовать парсинг

Использование аналитики, как правило, не запрещено законом. Конституция РФ гарантирует право свободно искать, получать и распространять информацию любым законным способом. Поэтому, если информация не защищена авторским правом, находится в свободном доступе для всех желающих, и нет других правовых запретов, ее можно копировать и распространять, причем способ копирования и распространения не имеет значения.

Однако помните, что существуют определенные виды информации, которые защищены законом. Примером может служить личная информация пользователя. Эта информация защищена Законом о персональных данных, и вы должны быть осторожны при ее анализе. Когда вы собираете личные данные, вы сообщаете об этом пользователю:

Поэтому анализ допускается, но его не следует путать с другими понятиями:

- Взлом сайта: когда данные берутся из личного кабинета пользователя.

- DDOS-атака: когда веб-сайт перестает работать из-за чрезмерного количества запросов к серверу.

- Заимствование защищенного авторским правом контента: заимствование защищенного авторским правом изображения или уникального текста и размещение его на своем сайте.

Такие действия представляют собой недобросовестную конкуренцию, запрещены и могут повлечь за собой штрафные санкции: Штрафы со стороны закона, поисковых систем, социальных сетей и т.д.

Анализ является законным до тех пор, пока вы собираете общедоступную информацию, не причиняя вреда другим людям.

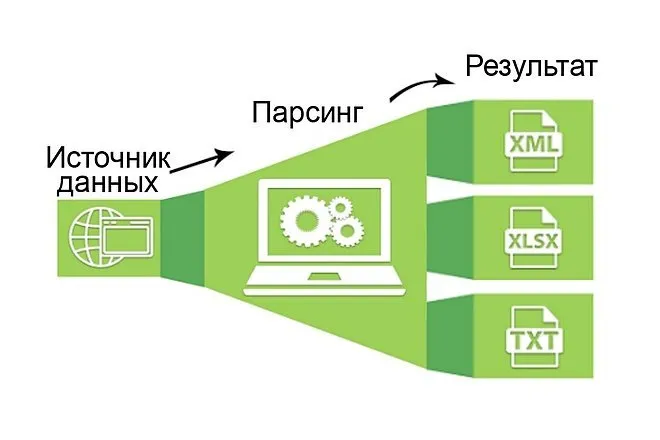

Алгоритм работы парсера

Аналитик — это робот. Он воспринимает информацию на сайте иначе, чем мы. Его не интересуют визуальные эффекты, он видит только код и содержание страницы. Программа находит информацию о заданных параметрах, сравнивает их, анализирует и сохраняет в нужном вам формате.

Объектом анализа может быть практически что угодно: обычный сайт, интернет-магазин, социальная сеть, своего рода каталог.

Сбор государственных данных разрешен Конституцией. Однако если личные данные пользователей собираются и используются для целевой рекламы или рассылки спама, это уже считается незаконным (нарушение Закона о персональных данных).

Парсинг: что это такое простыми словами

Анализ — это процесс автоматического сбора информации на основе заданных нами критериев. Для лучшего понимания давайте рассмотрим пример:

Пример аналитики: Представьте, что у нас есть интернет-магазин от поставщика, который позволяет нам работать по системе дропшиппинга, и мы хотим скопировать информацию о продукте из этого магазина и затем разместить ее на нашем сайте/в интернет-магазине (под информацией я имею в виду: название продукта, ссылку на продукт, цену продукта, изображение продукта). Как мы можем собирать эту информацию?

Первый вариант сбора — все вручную: то есть мы вручную проходим по всем страницам сайта, с которых хотим собрать информацию, и вручную копируем всю эту информацию в таблицу, которую потом размещаем на нашем сайте. Думаю, понятно, что этот метод сбора информации может быть полезен, если вам нужно собрать 10-50 продуктов. Что же делать, если информация, которую необходимо собрать, касается 500-1000 продуктов? В этом случае второй вариант является более подходящим.

Второй вариант — растратить всю информацию сразу: Мы используем специальную программу или сервис (об этом я расскажу ниже) и автоматически загружаем всю информацию в заранее подготовленную таблицу Excel. Этот метод сэкономит вам много времени, и вам не придется заниматься рутинными делами.

Кроме того, в качестве примера я взял только сбор информации в интернет-магазине. Аналитики могут быть использованы для сбора всей информации, к которой мы имеем доступ.

Грубо говоря, с помощью аналитики можно автоматизировать сбор любой информации на основе заданных нами критериев. Я думаю, очевидно, что ручной сбор информации неэффективен (особенно в наше время, когда информации слишком много).

Чтобы проиллюстрировать это, я хотел бы указать на основные преимущества анализа:

- Преимущество №1 — скорость. За единицу времени машина может предоставить во много раз больше деталей, или, в нашем случае, информации, чем если бы мы просматривали страницы сайта с лупой в руках. Именно поэтому компьютерные технологии превосходят ручной ввод данных при обработке информации.

- Преимущество №2 — Структура или «скелет» будущего отчета. Мы собираем только те данные, которые нас интересуют. Это может быть что угодно. Например, числа (стоимость, количество), изображения, текстовые описания, адреса электронной почты, имена, псевдонимы, ссылки и так далее. Нам просто нужно заранее подумать, какую информацию мы хотим получать.

- Преимущество №3 — Правильный вид отчета. Мы получаем конечный файл с набором данных в нужном нам формате (XLSX, CSV, XML, JSON) и можем сразу же использовать его, вставив в нужное место на вашем сайте.

Недостатком, конечно, является отсутствие уникальности в получаемых данных. В первую очередь это касается контента, потому что мы собираем все из открытых источников, и анализатор не делает собранную информацию уникальной.

Думаю, мы разобрались с концепцией аналитики, а теперь давайте рассмотрим конкретные программы и услуги для аналитики.

Что такое парсер и как он работает

Анализатор — это программа или алгоритм с определенной последовательностью действий, целью которых является получение заданной информации.

Сбор информации осуществляется в 3 этапа:

- Сканирование.

- Следующие действия выполняются в три этапа: Сканирование: 1.

- Выбираются следующие параметры: 1.

В большинстве случаев анализатор представляет собой платное или бесплатное программное обеспечение или услугу, разработанную для ваших нужд или выбранную вами для конкретных целей. Существует множество таких программ и услуг. Большинство из них написаны на Python или PHP.

Но есть и отдельные программы, с помощью которых можно писать анализаторы. Например, я использую ZennoPoster и пишу в нем анализаторы — с его помощью вы как разработчик можете создать анализатор, но он работает по тому же принципу, что и платные/бесплатные сервисы анализаторов.

Например, в этом видео я показываю, как я создал анализатор для сбора информации с сервиса spravker.ru.

Чтобы было легче понять, давайте обсудим типы и виды анализаторов, которые существуют:

- По способу доступа к онлайн-ресурсу. Анализатор может быть установлен или не установлен на компьютере (облачное решение),

- В зависимости от используемой технологии. Это программы, написанные на одном из языков программирования, или расширения для веб-браузеров, формулы в электронных таблицах Google или надстройки в Excel,

- По назначению. Проверять оптимизацию своего ресурса, анализировать данные пользователей и сообществ в социальных сетях, следить за конкурентами, собирать данные в определенной рыночной нише, анализировать цены и товары, необходимые для наполнения каталога интернет-магазина,

Не следует забывать, что анализ имеет и некоторые недостатки. Недостатком этого метода являются технические трудности, которые могут возникнуть у аналитика. Поэтому ссылки на сайт создают нагрузку на сервер. Каждое подключение программы регистрируется. Если вы часто входите в систему, сайт может заблокировать вас на основании вашего IP-адреса (но это можно легко обойти с помощью прокси-сервера).

Какие функции выполняют парсеры? Что с их помощью можно парсить?

Чтобы понять, что такое аналитика, что она означает в простых терминах, давайте рассмотрим области ее применения. Для сбора какой информации вам нужно написать или купить специальную программу?

Поэтому я определил следующие задачи для аналитика (на самом деле их гораздо больше):

- Аналитик для поиска описаний товаров и цен. Прежде всего, это интернет-магазины, которые используют специальные программы для сбора описаний и характеристик товаров, например. Затем он сразу же устанавливается на их веб-сайте. В этом случае можно быстро заполнить карточки товаров исходными данными (спецификации, описания, цены). Поскольку количество товаров может составлять сотни и тысячи наименований, другого более быстрого способа пока не существует. Должно быть сразу понятно, что эти описания не будут уникальными.

- Аналитик и редактор для страниц автозаполнения. Специально созданные парсеры с определенной частотой «перебирают» веб-ресурсы из определенного списка. Если там появляются новые предметы, они немедленно публикуются на их ресурсе.

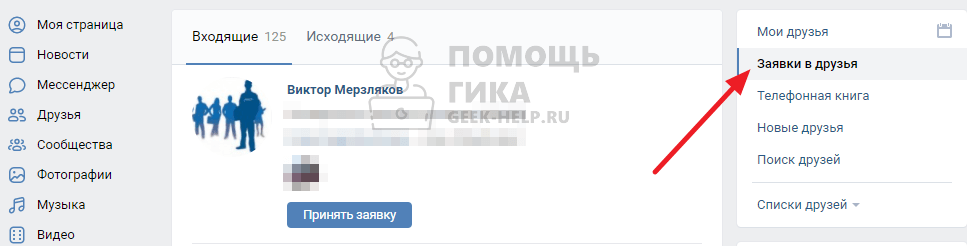

- Для получения персональных данных. Собираются персональные данные, например, об участниках определенных социальных групп на определенных ресурсах, о посетителях веб-сайтов или интернет-магазинов. Имена, фамилии, адреса электронной почты, номера телефонов, возраст, пол. Одним словом, все, что может быть использовано для определения вашей целевой аудитории — различных групп людей, объединенных одной или несколькими характеристиками.

Как правило, эти анализы используются для двух целей. 2. собирать личные данные (e-mail, номер телефона) для рассылки спама (я тоже, кстати, однажды этим грешил. Я уже писал об этом методе агитации в этой статье).

- Аналитики для обновления новостных лент. Онлайновые источники новостей содержат много динамичной информации, которая меняется очень быстро. Автоматический мониторинг погоды, дорожных условий и курсов валют делегируется аналитику.

- Для создания семантического ядра программное обеспечение осуществляет поиск ключевых слов (запросов) по определенной теме и определяет их частоту. Затем собранные ключевые слова объединяются в классы (кластеризация запросов). Затем на основе семантического ядра (SN) пишутся статьи для продвижения вашего ресурса в результатах поиска.

- Парсер, управляющий программой анализа сайта, находит заголовки и подзаголовки страниц, вплоть до 5-6 уровней, описания, изображения с их атрибутами и другие данные, которые он «возвращает» в виде таблицы. Такой анализ помогает проверить, соответствует ли сайт требованиям поисковых систем (такая проверка напрямую связана с продвижением ресурса в Интернете, ведь чем лучше отформатирован сайт, тем больше шансов, что он займет первые позиции в результатах поиска).

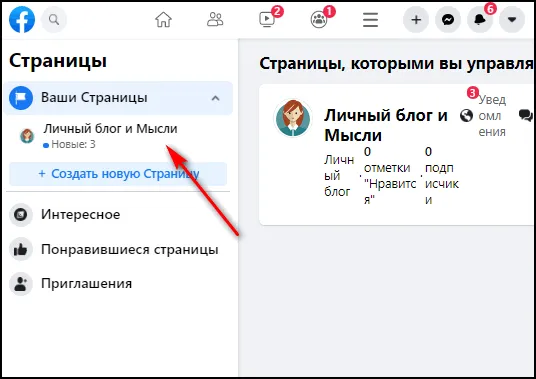

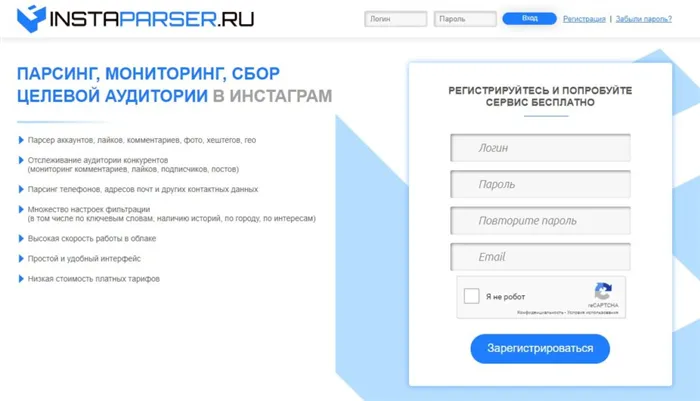

Для анализа в Instagram используются импровизированные и специальные программы, а также веб-сервисы. Причем некоторые из них не только собирают информацию, но и выполняют определенные действия, например, набирают лайки, массово подписываются на страницы пользователей и т.д.

“Что в резюме тебе моем?” или парсинг HH.RU

В последнее время запросы на анализ хедхантеров стали очень популярны. Действительно, вначале люди просят продать им «базу хедхантера». Но когда они уже понимают, что у нас нет и не может быть базы, мы переходим к обсуждению анализа их профиля («под паролем»). Это странное направление анализа, и, честно говоря, оно нас не особенно интересует, но его стоит обсудить.

Что самое сложное? Клиент получает доступ к своему аккаунту и ставит задачу по сбору данных для своих нужд. Он уже заплатил за доступ к базе данных HH и, подписавшись, несет полную ответственность за автоматический сбор данных, который происходит под его учетной записью. Если HH обнаружит какую-либо ненормальную активность, аккаунт будет заблокирован. Поэтому мы стараемся максимально имитировать деятельность человека во время сбора данных.

Если бы сам HH (насколько я знаю, он «успешно» провалил свои эксперименты с API) предоставлял (продавал) табличные данные по регионам, например, контакты всех менеджеров по маркетингу, работающих в настоящее время в Москве, к нам бы никто не пришел. Пока кому-то приходится делать это «вручную», они будут приходить к нам. Если у вас есть такая электронная таблица, гораздо удобнее бороться с рекламным спамом: Холодные звонки.

Я хотел бы повторить, что у нас нет базы данных HH, мы только собираем данные о каждом клиенте в отношении его потребностей, счета и обязанностей. И нарушение соглашения о торгах не связано с использованием стороной анализируемого ею веб-сайта. Подписав с нами контракт, клиент получает около 450 контактов PPR, которые мы размещаем на их сервере, а их отдел продаж затем решает, что с ними делать. Эй, мы бы спамили себя, если бы у нас была такая база. Шучу 🙂

Хотя лично я считаю, что анализировать пароли бесполезно. Однако анализ открытых источников — это совсем другое дело. Вы устанавливаете все один раз, постоянно анализируете, а затем продаете доступ ко всем собранным данным. Это более перспективно.

Парсинг вообще законен?

В российском законодательстве нет статьи, запрещающей парсинг. Хакерство, DDOS и кража защищенного авторским правом контента запрещены, но парсинг не является ни одним из этих пунктов, ни третьим и поэтому не запрещен.

Некоторые люди считают парсинг DDOS-атакой и относятся к нему с подозрением. Однако это совершенно разные вещи, и при парсинге мы вместо этого стараемся как можно меньше загружать целевой сайт и не вредить компании. Как и при здоровом паразитизме, мы не хотим, чтобы компания «нанесла ответный удар», потому что нам больше не на чем «паразитировать».

Обычно вас просят проанализировать крупные сайты, т.е. 300-500 наиболее важных сайтов в России. На таких сайтах обычно бывает несколько миллионов посетителей в месяц, а может быть, и больше. И на таком фоне анализ товара за одну-две секунды практически незаметен (нет необходимости анализировать чаще, 1-2 секунды на статью — это оптимальная скорость для крупных сайтов). Следовательно, в наших действиях нет признаков DDOS-атаки. Очень редко нас просят обновлять, например, весь сайт BERU.ru в день — это, прямо скажем, чрезмерно и слишком большая нагрузка для сайта… обычно это занимает 3-4 дня.

Хочу напомнить, что анализ — это лишь совокупность того, что мы можем увидеть глазами на сайте и скопировать от руки. Таким образом, под статью об авторском праве могут попасть только действия с уже собранной информацией, то есть действия самого заказчика. Человек просто делает это медленно и с ошибками в течение длительного времени, в то время как аналитик делает это быстро и без ошибок. Что же делать, когда нужно собрать данные с AliExpress или Wildberies? Человек просто не в состоянии справиться с такой задачей, и аналитика — единственный выход.

Однако недавно меня попросили проанализировать сайт правительственного учреждения: суда, если я не ошибаюсь. Там вся информация открыта, а мы отказываемся (к лучшему или худшему) 🙂

“Вы чего нас парсите, мы же заказчик” или в чем разница между парсингом и мониторингом цен?

Мониторинг цен — одно из самых популярных приложений для анализа. Но не все так просто — в этом случае мы должны работать не только на себя, но и на клиента.

Когда вы размещаете заказ на мониторинг цен, мы сразу указываем, что будем анализировать не только наших конкурентов, но и клиента. Это необходимо для получения аналогичных таблиц продуктов и цен, которые мы сможем обновлять автоматически. Однако сами по себе эти данные ничего не стоят, поскольку они не связаны друг с другом (так называемое сопоставление продуктов). Мы можем сопоставить некоторые данные с разных сайтов автоматически, но, к сожалению, «машины» сейчас недостаточно хороши, чтобы сделать это гарантированно безошибочно, и никто не сделает это лучше, чем человек (например, сотрудник из регионов на полставки).

Если бы все показывали штрих-код на сайте, это было бы замечательно, и мы могли бы делать всю эту «кучу» автоматически. К сожалению, это не так, и даже названия продуктов разные компании пишут по-разному.

Хорошо то, что это задание нужно выполнить только один раз, а затем мы можем проверять его снова через регулярные промежутки времени и при необходимости вносить небольшие коррективы. Создавая ссылки, мы уже можем автоматически обновлять такие таблицы. В конце концов, людям не нужно следить за ценами на все: Обычно в верхней части находится от 3 до 5 тысяч позиций, а мелкие позиции не представляют интереса. И местный оператор может легко выполнить такую работу примерно за 10 000 рублей в месяц.

На мой взгляд, самый удачный и правильный путь в этом случае — загрузить прайс-лист конкурентов прямо в 1С-ку (или другую ERP-систему) и уже там провести сравнение. Это самый простой способ интегрировать мониторинг цен в повседневную деятельность ваших аналитиков. А такой анализ без анализа никому не нужен.

Англо-русский словарь является тому примером. У нас есть оригинальное слово «разбор». Мы открываем словарь и находим его. И в результате получается перевод слова parsing или analysis. Теперь давайте рассмотрим это подробнее.

Как парсить сайты и обрабатывать данные

В качестве примера поясним, как можно проанализировать товары из интернет-магазина.

Вы должны четко понимать, что вам нужно собрать. Программы имеют множество фильтров, с помощью которых можно сразу отсечь все ненужное. Например, вам нужны товары только из определенного отдела или с определенными ключевыми словами. Возможно, достаточно каталога и прайс-листа без текста и атрибутов.

Найдите донорский сайт (или несколько). Донор должен быть указан в специальном окне программы.

Установите фильтры, измените настройки (для каждого сервиса свои) и начните сбор данных.

Форматирование данных в файле (текст, таблица, файл и т.д.). Подходящий формат файла задается в настройках сервиса.

Эти данные могут быть использованы различными способами. Данные о ценах, счетах и объемах продаж используются для маркетингового анализа конкурентов.

Для сбора семантического ядра используется список ключевых слов из ведущих поисковых систем.

Контент может быть импортирован на ваш собственный сайт (например, в агрегатор). Текстовые данные иногда используются повторно (например, с помощью синонимайзера). Контент одного автора не может быть использован, так как это является нарушением авторских прав.

Анализ конкурента — Самоанализ полезен при сравнении информации на двух сайтах. Этот процесс позволяет добавить недостающую информацию (например, сведения о продукте) на ваш сайт.

Читайте на AskUsers

Агрегированные веб-сайты все чаще появляются в верхней части списков поисковых систем при коммерческом поиске. Это платформы, похожие на каталоги, которые объединяют продукты, услуги, сервисы или новости. Узнайте, как создать и продвигать агрегатор.

Google Sheets — это удобный инструмент для планирования (например, прибыли и затрат), маркетингового анализа, отслеживания продаж и многого другого. Мы подготовили отличное руководство по использованию Google Sheets.

Открою вам секрет: все они анализируют…. По крайней мере, все основные продавцы на рынке. Несколько лет назад представители «М-Видео», «Связного» и «Ситилинк» даже открыто говорили об этом в статье в газете «Ведомости», отвечая на интерес Федеральной антимонопольной службы (см. здесь).

Достоинства парсинга

Они многочисленны. По сравнению с людьми, аналитики могут:

- Собирайте данные быстрее и в любом режиме, даже круглосуточно,

- соблюдать все заданные параметры, даже очень тонкие,

- избегать ошибок, связанных с невнимательностью или усталостью,

- регулярные проверки через определенные промежутки времени (каждую неделю и т.д.),

- представить собранные данные в любом желаемом формате без лишних усилий,

- равномерно распределять нагрузку на страницу анализа (обычно одна страница в 1-2 секунды), чтобы не создавать эффект DDOS-атаки.

Ограничения при парсинге

Существует несколько вариантов ограничений, которые могут затруднить работу с анализатором:

- Через агент пользователя, т.е. запрос, который использует программное обеспечение, чтобы сообщить сайту о себе. Анализаторы запрещают многие интернет-источники. Однако вы можете изменить эти данные в настройках YandexBot или Googlebot и отправлять правильные запросы.

- С помощью robots.txt, который предусматривает, что поисковым роботам Яндекса или Google (представленным на вышеуказанном сайте) запрещено индексировать определенные страницы. Необходимо настроить параметры программы таким образом, чтобы robots.txt игнорировался.

- На основании IP-адреса, если веб-сайт получает однотипные запросы в течение длительного периода времени. Решением является использование VPN.

- С капчей. Если действия похожи на автоматические действия, отображается капча. Научить аналитиков распознавать определенные типы сложно и дорого.

Какую информацию можно парсить

Все, что находится в открытом доступе на сайте, может быть разобрано. Наиболее распространенными типами являются:

- Названия и категории продуктов,

- ключевые особенности,

- цена,

- информацию об акциях и новых продуктах,

- тексты описания товара для последующей настройки и т.д.

Изображения с веб-сайтов технически также можно хранить, но, как уже говорилось выше, лучше этого не делать, если они защищены авторским правом. Другие сайты не могут собирать личные данные, которые их пользователи ввели в свои личные кабинеты.

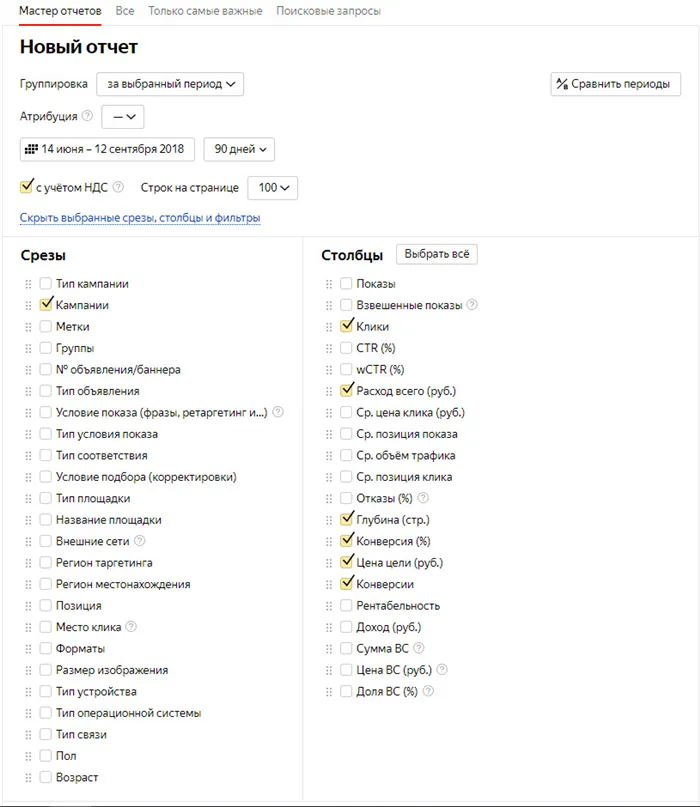

Аналитика часто используется в индустрии электронной коммерции. Оценить влияние аналитики и ее результаты можно в сквозной аналитике для интернет-магазинов. Отчеты доступны для любых периодов времени, метрик и продуктов. С помощью этих данных вы узнаете, из каких источников вы получаете трафик корзин и продажи, и сможете оптимизировать свои объявления на основе этих данных.

- Отслеживайте корзины, звонки, лиды и продажи со ссылкой на источник.

- Создайте свою воронку продаж и оптимизируйте маркетинг

Бесплатная версия ограничена 500 url. В платной версии (лицензию можно приобрести на один год) количество анализируемых страниц не ограничено, и она имеет гораздо больше возможностей. Это включает анализ цен, названий и описаний товаров на любом сайте. Как это сделать, мы подробно описали в руководстве.

Парсинг — это законно?

Сбор публичной информации в Интернете не запрещен российским законодательством. Более того, статья 29(4) Конституции закрепляет право «свободно искать, получать, передавать, производить и распространять информацию любым законным способом». Анализ данных часто сравнивают с фотографированием ценников в магазинах: Если информация находится в общественном достоянии, то есть не защищена авторским правом или другими ограничениями, ее можно копировать и распространять.

В отношении интернет-данных это означает, что сбор информации, на которую не требуется лицензия, является законным. Однако личные данные пользователей защищены отдельным законом и не могут быть использованы в целях целевой рекламы или кампаний по электронной почте.

Кому и зачем нужны парсеры сайтов

Аналитики экономят время на сбор большого количества данных и их группировку в нужном формате. Такими услугами пользуются интернет-маркетологи, веб-мастера, SEO-специалисты и маркетологи.

Аналитики могут выполнять следующие задачи:

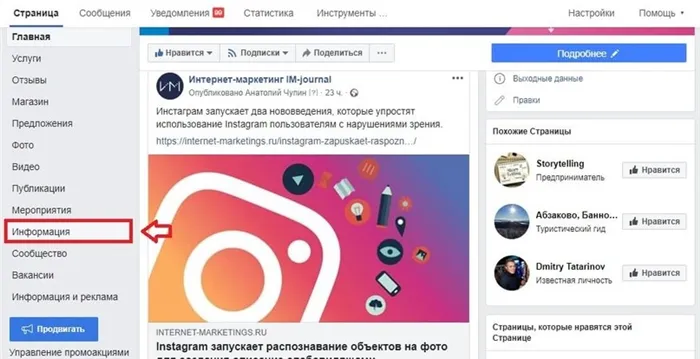

- Цены и разнообразие коллекционирования. Это полезно для интернет-магазинов. С помощью анализатора вы можете отслеживать цены конкурентов и пополнять каталог на своем ресурсе в автоматическом режиме. (title, description, заголовки H1) полезно для SEO-специалистов.

- Анализ технической оптимизации ресурса (битые ссылки, 404 ошибки, неработающие редиректы и т.д.) будет полезен SEO-специалистам и веб-мастерам.

- Программы для скачивания целых веб-сайтов или анализа содержимого (тексты, изображения, ссылки) находятся в «серой зоне». С их помощью недобросовестные веб-мастера клонируют сайты, чтобы перепродавать с них ссылки. Это включает анализ данных агрегаторов и картографических сервисов, таких как Avito, Яндекс.Карты, 2gis и другие. Собранные базы данных используются для звонков и спама.

Для кого и для каких целей нужна аналитика, засекречена. Если вам нужен этот инструмент, есть несколько способов его получить.

- Если у вас есть разработчики, самый простой способ — попросить их разработать аналитический инструмент для нужной вам цели. Это обеспечит вам гибкость и немедленную техническую поддержку. Наиболее популярными языками для создания анализаторов являются PHP и Python.

- Используйте бесплатную или платную облачную службу.

- Установите программное обеспечение, соответствующее вашим потребностям.

- Обратиться в компанию, которая разрабатывает инструмент для ваших нужд (вероятно, самый дорогой вариант).

С первым и последним вариантами все понятно. Однако выбор готовых решений может отнять много времени. Мы упростили эту задачу и создали обзор инструментов.

Классификация парсеров

Анализаторы можно классифицировать по-разному.

- В зависимости от того, как осуществляется доступ к интерфейсу: Облачные решения и программы, требующие установки на компьютер.

- По технологиям: анализаторы на основе языков программирования (Python, PHP), расширения для браузеров, дополнения для Excel, формулы в электронных таблицах Google.

- Цель: Наблюдение за конкурентами, сбор данных о конкретной нише рынка, анализ товаров и цен для наполнения каталога интернет-магазина, анализ данных социальной сети (сообщества и пользователи), проверка оптимизации вашего ресурса.

Давайте проанализируем аналитику по разным причинам и для разных целей.

Очень часто я вижу вопрос «пример парсера для Instagram» или «пример парсера для социальных сетей», поэтому давайте разберемся, что значит парсер для социальных сетей, групп и аккаунтов?

Как использовать парсер для различных целей

Реализация программы сбора данных осуществляется в соответствии с поставленными задачами. От этого зависит выбор типа и функциональности услуги.

Парсинг интернет-магазина

Одно из самых распространенных применений парсеров — это получение данных с онлайн-маркетов или онлайн-каталогов для наполнения собственного интернет-магазина товарами, ценами и описаниями.

Какие задачи можно решить, используя автоматизированные сервисы для сбора, анализа и преобразования данных?

- Обновление информации. Если цены поставщиков меняются, вам необходимо пересчитать свои ценовые предложения для всех категорий товаров. Если каталог содержит тысячи наименований, это очень сложно и дорого. Поэтому здесь уместны специальные плагины, которые собирают данные и позволяют обновлять всю информацию.

- Анализ конкурирующих интернет-магазинов. Этот вид анализа проводится для поддержания цен на рыночном уровне.

Парсинг контента

Для поиска и анализа текстов и другого контента используется специальная программа анализа. Он настраивается в соответствии с поставленными задачами — анализ опубликованных статей, описание характеристик или комментарии к каталогу продукции.

Как парсить сайт интернет-магазина

Для правильного сбора данных программа анализа или расширение должны быть правильно настроены. Конфигурация модуля позволяет правильно определить макет сайта — расположение и структуру категорий и подкатегорий, карты товаров. После этого можно получить всю необходимую информацию из электронного источника.

Алгоритм действий для анализа интернет-магазина:

- Добавьте ссылку на онлайн-ресурс (на сайт или подразделы).

- Определите места (блоки), где вы хотите получить необходимые данные.

- Загрузка данных с веб-сайта.

- Сохранение данных в файле Excel (XLSX) или загрузка информации о продукте на нужный веб-сайт или в онлайн-каталог в Интернете.

Теги, которые используются для парсинга онлайн-магазина

При разработке интернет-магазинов любого размера и структуры используется язык HTML и стандартные блочные элементы. Поэтому типичные аналитики используют стандартные HTML-теги, которые можно найти на страницах интернет-магазинов:

- Тег div. Этот блочный элемент позволяет добавить визуальный контент в раздел.

- Тег a. Отображает ссылки на продукты в выбранной категории продуктов.

- Тег h1 и т.д. Отображает заголовки разных уровней. Заголовками могут быть названия продуктов и других блоков.

- Тег p. Используется для отображения разделов текста, например, описания товара и т.д.

- Таблица тегов. Отображает таблицы.

- Тег ul. Указывает на агрегированный список (список продуктов и т.д.).

- Этикетка с изображением. Отображение фотографий или других изображений.

Настройки по умолчанию позволяют выбрать именно те части информации, которые нужны для анализа или других целей.

С помощью программ анализа можно быстро собрать и упорядочить большие объемы данных. Это необходимо для анализа цен и продукции конкурентов, а также для обновления данных о товарах и услугах. Когда вы работаете с десятками производителей, удобно использовать сервисы аналитики для обновления и добавления информации об этих продуктах. Нет необходимости вносить изменения вручную, гораздо быстрее и проще использовать эту программу.