Техника анализа работает следующим образом: Этап 1: Подача заявки. Пользователь вводит в программное обеспечение соответствующие условия для образца. Это могут быть, например, товарные позиции, ценники, желаемый возраст лидов или их место жительства.

Автоматизированный парсинг сайтов

В работе IT-специалистов часто возникает задача сбора определенной информации с веб-сайтов, например, необходимость проконсультироваться по продукции с сайта конкурента. И это не может быть легко априори.

Поэтому был разработан автоматизированный и упрощенный анализ извлечения и агрегирования данных.

В этом посте я собрал информацию о том, что это такое, как это работает и почему, а также о методах и инструментах, которые облегчат вам анализ.

Что такое парсинг сайтов

Анализ — это автоматическое извлечение большого количества данных из онлайн-ресурсов с помощью специальных скриптов в несколько этапов:

- Создание запроса для получения исходной информации.

- Формирование запроса путем создания запроса для извлечения информации в соответствии с заданным алгоритмом.

- Генерация и структурирование информации.

- Хранение данных.

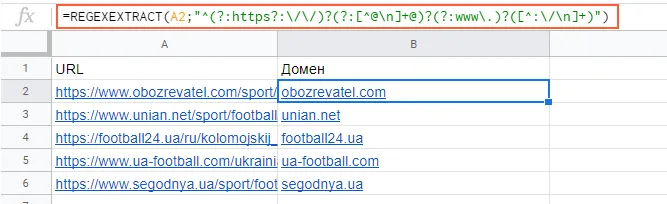

Для того чтобы получить только определенные данные, в программе задается специальный язык поиска, который описывает шаблоны строк — регулярное выражение. Регулярное выражение основано на использовании набора определенных символов, которые описывают информацию, подлежащую поиску. Более подробную информацию о работе с регулярными выражениями можно найти на их веб-сайте.

Инструменты парсинга, называемые парсерами, — это боты, которые запрограммированы на ползание по базам данных и извлечение информации.

Как правило, синтаксические анализаторы настроены на:

- Определите уникальный HTML,

- извлекать и преобразовывать содержимое,

- хранить очищенные данные,

- экспортный API.

Зачем и когда используют парсинг

Для таких целей часто используется парсинг:

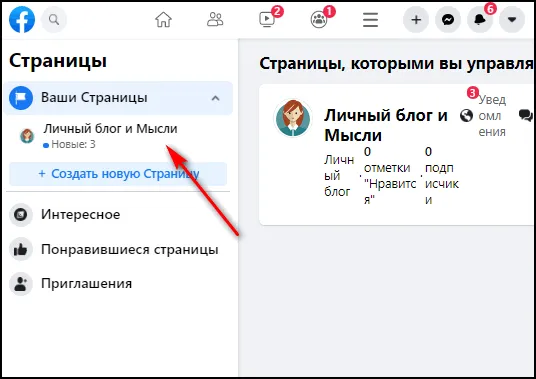

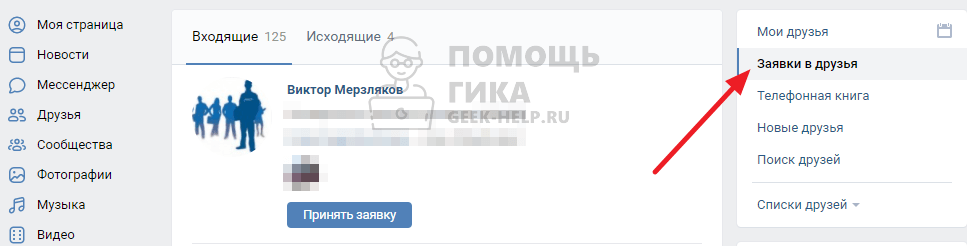

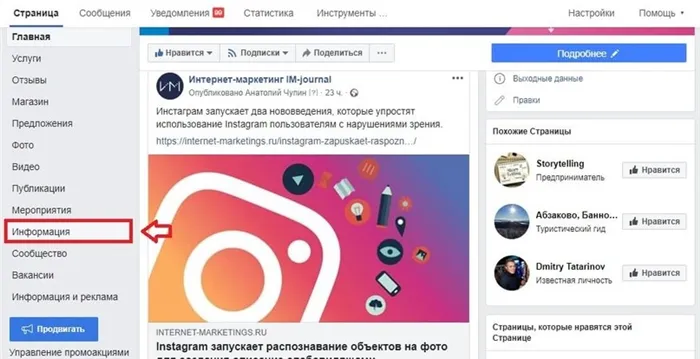

- Извлечение контактной информации. Парсинг помогает получать электронные письма и номера телефонов с различных веб-сайтов и социальных сетей.

- Проверка текстов на уникальность.

- Определение цен и предложений конкурирующих продуктов.

- Исследование рынка, например, наблюдение за ценами конкурентов, чтобы работать с ценами на их продукцию.

- Преобразование веб-сайтов в API. Это полезно, если вы хотите работать с данными с сайтов, у которых нет API, и вам нужно создать его для них.

- Мониторинг информации для поддержания ее в актуальном состоянии. Часто используется в областях, где информация меняется быстро (прогнозы погоды, курсы валют).

- Копирование материалов с других сайтов и вставка их на свой сайт (часто используется на сайтах-сателлитах).

Это наиболее распространенные примеры анализа. Их может быть столько, сколько позволит ваше воображение.

3. Как парсить данные с помощью различных сервисов и инструментов

К счастью, существует множество способов анализа данных сайта: платные и бесплатные, сложные и простые.

Я предлагаю вам ознакомиться с различными типами представителей и проанализировать, как работает каждый из них.

Google Spreadsheet

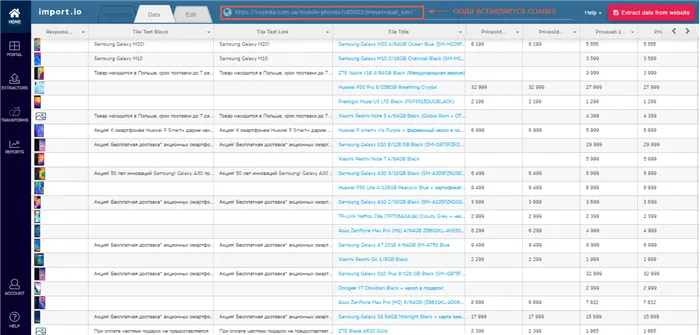

Функции электронных таблиц Google можно использовать для анализа метаданных, названий, наименований товаров, цен, списков рассылки и многого другого.

Давайте рассмотрим самые популярные и полезные функции и то, как они работают.

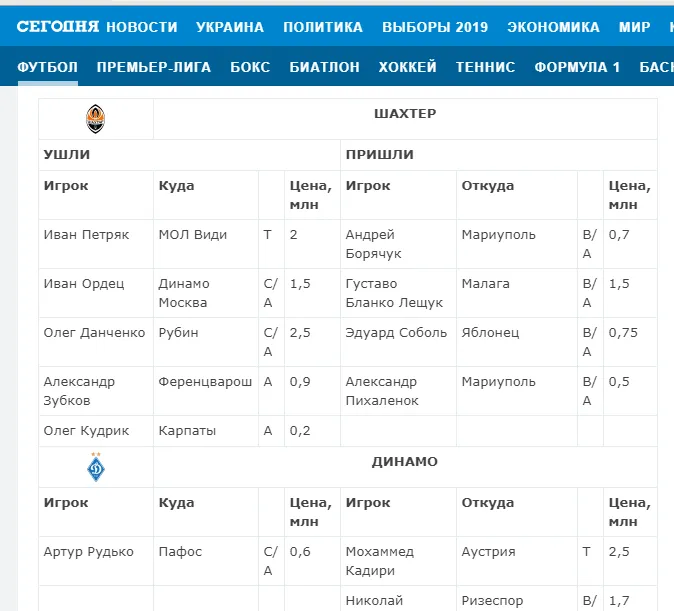

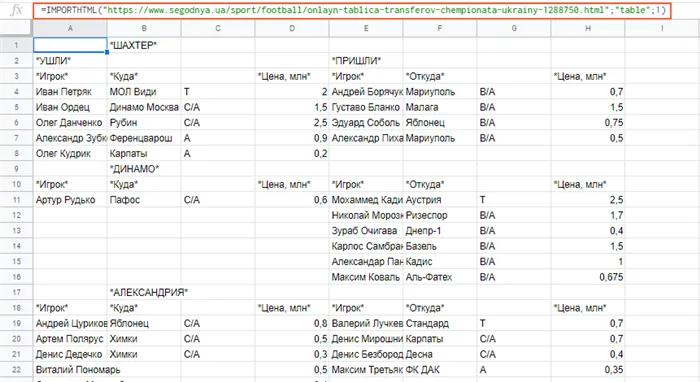

Функция importHTML

Настраивает вставку таблиц и списков на страницах веб-сайта. Это обеспечивается следующим образом:

Пример использования

Необходимо выгрузить данные в формате таблицы со страницы сайта.

Для этого введите URL страницы, добавьте тег «table» и порядковый номер — 1 к типу.

Вот результат:

Введите формулу в таблицу и просмотрите результат:

Функция importXML

Импортирует данные из документов HTML, XML, CSV, TSV, RSS и ATOM XML.

Этот режим предлагает более широкий спектр возможностей, чем предыдущий. Его можно использовать для сбора практически любой информации со страниц и документов.

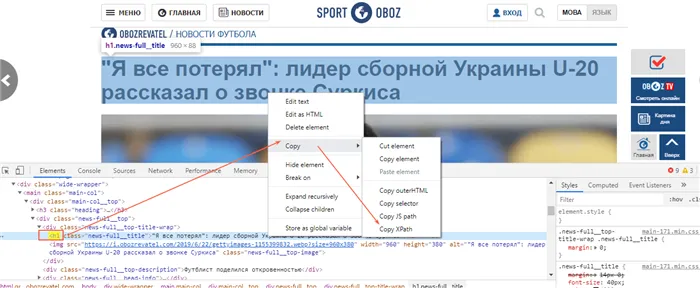

Эта функция основана на языке запросов XPath.

Пример использования

Перетаскивание заголовка и метаописания. В первом случае мы просто пишем название слова в формуле:

Вы также можете добавить в формулу имена ячеек, содержащих нужные вам данные.

При разборе описания вам придется проделать немного больше работы, т.е. написать XPath. Это будет выглядеть следующим образом:

Для всех остальных данных XPath может быть скопирован непосредственно из кода страницы.

Вставьте формулу и получите содержание метаописания.

— VK. БАРКОВ NET (ссылка) — ресурс с опытом анализа/анализа аудитории ВКонтакте. Бесплатная версия предлагает самый широкий спектр инструментов специфического анализа,

Зачем нужен парсинг данных

Его можно использовать для следующих целей:

- Анализ веб-сайтов конкурентов. Вам больше не придется вручную искать на десятках чужих сайтов.

- Просматривать изменения на веб-сайтах вместо того, чтобы иметь дело с тысячами других веб-сайтов, вместо того, чтобы иметь дело с тысячами других веб-сайтов. Такую же аналогию можно провести со стоимостью продукции на сайтах конкурентов. Будет легче отслеживать изменения цен в любое время года или перед праздниками.

- Проанализируйте свой собственный сайт. Например, для «наведения порядка» — быстрого поиска удаленных страниц, устранения противоречивых данных и неполной информации.

- Наличие дубликатов страниц, безопасность, правильность всех технических параметров: Перенаправления, robots.txt, скорость загрузки sitemap.xml и т.д.

- Техническая оптимизация — один из важнейших этапов продвижения.

Это основные функции анализа. Каждый пользователь может найти в этом процессе что-то новое и полезное для себя. Например, для проведения SEO-оптимизации их сайта.

Плюсы и минусы

Как и у любого инструмента, у него есть положительные и отрицательные стороны.

- Вы экономите время, поскольку вам не нужно самостоятельно собирать и искать необходимую информацию,

- способность выполнить задание максимально точно: например, найти интересы людей только во «ВКонтакте» или узнать цены на медведей в 10 магазинах Ульяновска,

- нет человеческого фактора — программное обеспечение ничего не потеряет. Только в некоторых случаях, когда настройки перепутаны, может возникнуть ошибка,

- самостоятельное преобразование данных в нужный формат. Например, файлы CSV могут быть преобразованы в XLSX, DOCX и т.д,

- Анализа можно избежать как DDoS-атаки, равномерно распределив нагрузку по сайту.

- Некоторые IP-адреса могут быть защищены от анализа, поэтому не вся информация может быть собрана; это может замедлить процесс,

- Анализатор может перестать работать, если у сайта большое количество пользователей, так как программа не может обновить страницу, чтобы она лучше загружалась.

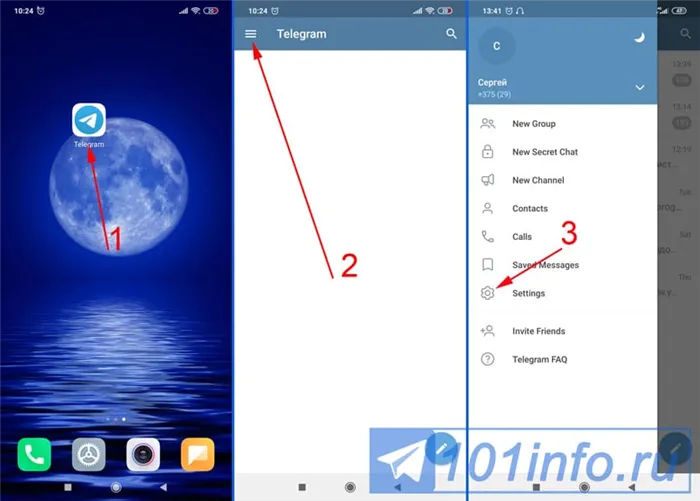

- Теперь вы можете читать последние новости из мира интернет-маркетинга в мессенджере Telegram на своем мобильном телефоне.

- Для этого вам необходимо подписаться на наш канал.

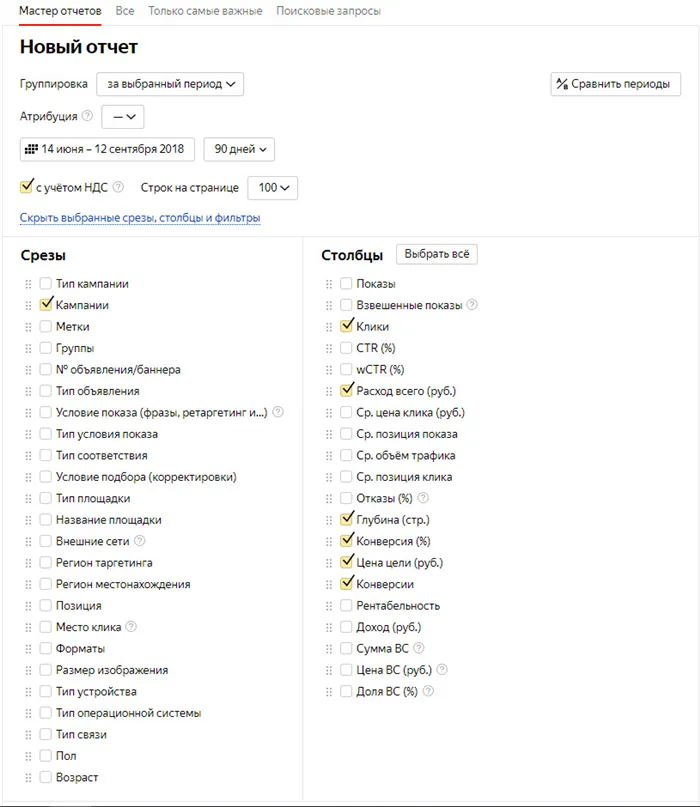

Как происходит парсинг данных

Мы расскажем вам об основных шагах и популярных аналитических сервисах.

Этапы

Техника анализа работает следующим образом: Этап 1: Подача заявки. Пользователь вводит в программное обеспечение соответствующие условия для образца. Это могут быть, например, товарные позиции, ценники, желаемый возраст лидов или их место жительства.

Фаза 2: Аналитик начинает работу и собирает данные с сайта. При правильном выполнении программы этот процесс занимает буквально несколько минут.

Шаг 3: Сортировка данных по определенному признаку: по алфавиту, по цифрам и т.д. Например, программа распределяет полученные данные об участниках онлайн-группы в виде таблицы. В одной колонке указывается возраст, в другой — место жительства, в третьей — образование.

Шаг 4: Вы получаете отчет с данными. Отчет может содержать примечания: Например, если он проанализировал ошибки, они будут показаны.

Шаг 5: Загрузите результаты. Рекомендуется сохранить данные отчета в формате CSV или XML, чтобы можно было открыть документ в Microsoft Excel, Google Sheets и других программах электронных таблиц.

В целом, анализатор — это программа для анализа ключевых слов на веб-сайтах. Он настраивается, введите параметры поиска и другие инструкции, чтобы получить семантическое ядро или анализ карты продукта для онлайн-бизнеса.

Для чего нужен парсинг данных сайта

Нелегко систематизировать большие объемы данных вручную. Анализ данных помогает:

- Заполнение карточек товаров на новом сайте — очень трудоемко заполнять их вручную,

- Приведите свой сайт в порядок — анализ поможет вам найти страницы с ошибками, карточки товаров с неправильными описаниями, дубликаты, ошибки в информации об остатках товаров на складе,

- оценить среднюю стоимость продукта, получить информацию от других компаний на рынке,

- отслеживать изменения, такие как повышение цен или инновации прямых конкурентов,

- собирать тексты с иностранных сайтов и переводить их автоматически.

Плюсы парсинга

По сравнению с ручным сбором данных, компании могут собирать данные с помощью аналитиков:

- собирать данные без ошибок,

- учитывать все параметры при поиске,

- собирать данные быстро, 24 часа в сутки, регулярно — каждый месяц,

- собирать информацию в нужном формате: XLSX, XML, CSV, JSON,

- они не загружают сайт, чтобы избежать эффекта, подобного DDOS,

- загрузить данные на веб-сайт.

Законно ли использовать парсинг

Иногда анализ воспринимается негативно. Однако в действительности анализ не противоречит закону, и за него не предусмотрена юридическая ответственность.

Закон запрещает следующее:

- Сбор данных с личных аккаунтов пользователей,

- DDOS-атаки (распределенные атаки типа «отказ в обслуживании») — это серия действий, которые могут вывести из строя веб-сайт,

- копирование содержимого: Изображения, тексты.

Анализ не противоречит закону, когда программы собирают данные из общественного достояния. Эта информация также может быть собрана вручную. Аналитики просто ускоряют процесс и устраняют неточности.

То, как владелец распоряжается собранной информацией, может быть незаконным — например, если компания полностью копирует статьи конкурентов.