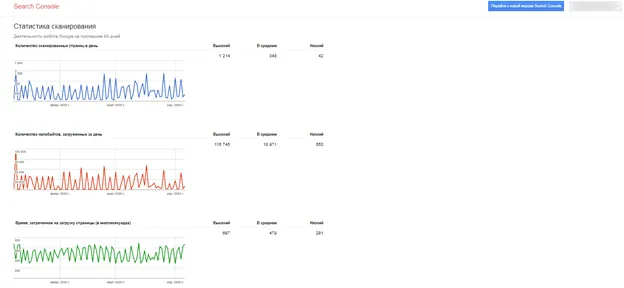

Все это определяется поисковой системой. Следовательно, никаких общих данных извлечь нельзя, но мы можем посмотреть на поведение типичного паука, взяв в качестве примера паука Googlebot:

Какую работу выполняют роботы-пауки поисковиков

Краулер (робот поисковой системы, бот, паук) — это программный модуль поисковой системы, который отвечает за сканирование веб-сайтов и добавление контента в базу данных.

Поисковый паук посещает миллионы сайтов с гигабайтами текста без вмешательства оператора. Принцип его работы схож с принципом работы веб-браузеров: Сначала оценивается содержание документа, затем материал сохраняется в базе данных поисковой системы, а затем связывается с другими сегментами.

Какую работу выполняют роботы пауки поисковых машин

Не зная, как работают поисковые роботы, веб-мастера воображают, что это какие-то могущественные существа. Но все гораздо проще: каждый бот отвечает за свою функцию.

Они не могут «шпионить» за закодированными частями сайта, разбираться в работе фреймов, JavaScript или Flash-анимации. Все зависит от функций, заложенных в них разработчиками.

Скорость индексации и частота ползания во многом зависят от регулярности обновления контента и массы внешних ссылок. Для того чтобы робот мог проиндексировать все страницы, следует создавать карты сайта в форматах .html и .xml.

Поисковая выдача формируется в 3 этапа:

- Сканирование — поисковые роботы фиксируют содержимое сайта (текст, фотографии и видео).

- Индексирование — робот вводит собранную информацию в базу данных и присваивает каждому документу определенный индекс. Материалы могут оставаться в быстром выводе в течение нескольких дней и получать трафик.

- Вывод результатов — каждая страница ранжируется в соответствии с результатами ранжирования в алгоритмах поисковых систем.

Google и Яндекс часто вносят коррективы в работу краулеров поисковых систем, например, ограничивают объем текста, который может быть проползен, или глубину веб-страницы паука. Веб-мастерам приходится адаптироваться к изменениям в SEO-продвижении: выбирать оптимальный размер текстов, ориентироваться на конкурентов в топ-10, учитывать вставку материалов, перелинковку материалов и т.д.

Каждая поисковая система, будь то Google или Яндекс, имеет своих «пауков», отвечающих за различные функции. Их количество варьируется, но задачи у них практически одинаковые.

Как управлять поисковыми ботами?

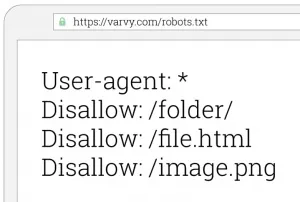

Часто операторы сайтов ограничивают доступ к определенному контенту для поисковых роботов, которые не должны участвовать в поиске. Все команды паукам задаются в специальном файле robots.txt.

Документ предоставляет трекерам список документов, которые не подлежат индексации (это могут быть технические части сайта или личные данные пользователей). Прочитав правила, робот покидает сайт или переходит на страницы, которые ему разрешено просматривать.

Что должно быть указано в файле robots.txt:

- Закрывать/открывать части контента или части сайта для индексации.

- Временные интервалы между запросами от поисковых ботов.

Команды могут быть общими для всех ботов или отдельными для Yandex, Googlebot, Mail.Ru. Подробнее о работе с robots.txt читайте здесь.

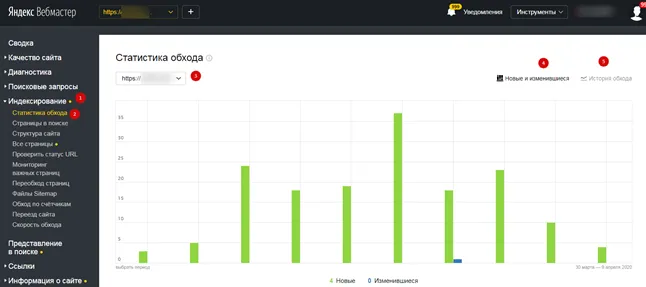

В панели управления вебмастера перейдите на страницу Индексирование, а затем на страницу Статистика обхода. Данные обновляются ежедневно, не позднее чем через 6 часов после того, как робот зашел на страницу.

Виды поисковых роботов

Во Всемирной паутине существует множество пауков, и у каждого из них своя работа. «Кто-то» реагирует на новые изображения, «кто-то» выделяет новый текст, «кто-то» специализируется на видео.

Примерный список поисковых систем выглядит следующим образом:

— Национальный. Программы этого уровня собирают данные из одного национального домена верхнего уровня.

— Глобальный. Эти пауки собирают информацию со всех национальных веб-ресурсов

— Роботы отслеживают новые графические, видео- и аудиофайлы.

— Зеркальные ползунки. Они находят копии веб-сайтов на других серверах

— Линк-краулеры. Вести точный учет ссылок на сайте

— «Объективные» роботы. Они отмечают комбинации слов в тексте, которые используются в качестве поисковых запросов

— Рецензенты. Эти программы проверяют присутствие сайта в базах данных поисковых систем и определяют количество проиндексированных файлов.

— Информанты. Их задача — выявить веб-сайты, которые недоступны, но связаны с

— Роботы-шпионы. » Они тайно ищут сайты, которые еще не были включены в базы данных поисковых систем.

— Перестраховщики. Активируются вручную и заняты перекрестной проверкой полученных данных.

— Поисковые машины. Необходим для оптимизации поисковых алгоритмов и изучения различных интернет-ресурсов.

— Спринтер. Автоматически сканирует дату последнего обновления и быстро индексирует обновленную информацию.

Для чего вообще нужны поисковые роботы?

Эти программы помогают пользователям Интернета получить точные и качественные ответы на свои вопросы.

А поисковые роботы облегчают владельцам сайтов продвижение ресурса. Как сделать свой сайт популярным, как увеличить посещаемость? Для этого нужно следить за тем, чтобы краулеры приходили часто. Качественный трафик обеспечивается поисковыми системами, потому что поисковые системы направляют на ваш сайт заинтересованных людей — потенциальных потребителей полезной информации, продуктов или услуг.

Поэтому очень важно, чтобы ваш ресурс занимал первое место в результатах поиска. Роботы постоянно индексируют и оценивают новые данные. Первые ряды результатов показывают 10 самых качественных и популярных онлайн-ресурсов. Они дают наиболее точные и полезные ответы на вопросы пользователей.

Как «заманить» робота на свой сайт?

Если паук еще не посетил ваш сайт, а вы хотите, чтобы пользователи как можно скорее посетили ваши страницы, помогите пауку.

Чтобы «поторопить» трекер, чтобы он достиг вашего сайта, разместите его в специальных каталогах, сообщите о нем в социальных сетях. Откройте свой веб-ресурс в Интернете — и робот поисковой системы без промедления добавит его в базу данных.

Индексирующие боты будут «любить» ваш сайт, если он постоянно обновляется. Регулярно публикуйте новые статьи, фотографии и видео. Чтобы стать популярным, веб-ресурс должен развиваться и реагировать на любые изменения в поведении пользователей.

Поисковые системы реагируют на частоту обновления контента. Если новая информация появляется на сайте раз в неделю, краулеры не будут приходить чаще. Однако социальные сети, крупные новостные порталы и просто очень популярные ресурсы будут проиндексированы в течение нескольких минут после обновления.

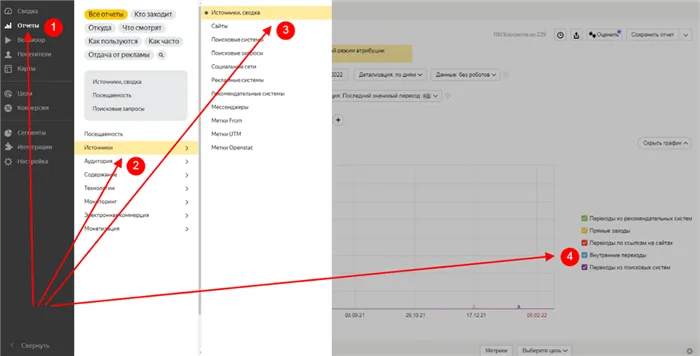

В панели управления вебмастера перейдите на страницу Индексирование, а затем на страницу Статистика обхода. Данные обновляются ежедневно, не позднее чем через 6 часов после того, как робот зашел на страницу.

Поисковой паук (краулер): виды и функции

Поисковый паук (также известный как робот, веб-паук, краулер) — это программа поисковой системы, которая просматривает интернет-ресурсы, чтобы найти информацию о них в базе данных.

Зачем создавать поисковых пауков?

Давайте рассмотрим элементарный пример. Представим себе Иванова Валерия, который регулярно посещает сайт http://it-ebooks.info/, где ежедневно публикуются новые электронные книги. Зайдя на ресурс, Валерий выполняет указанную последовательность действий:

1) Он открывает главную страницу,

2) Перейдите в раздел «Недавно загруженные проекты»,

3) оцените новинки из каталога,

4) кликает по ссылкам, когда появляются интересные заголовки,

5) читает резюме и скачивает файл, если он интересен.

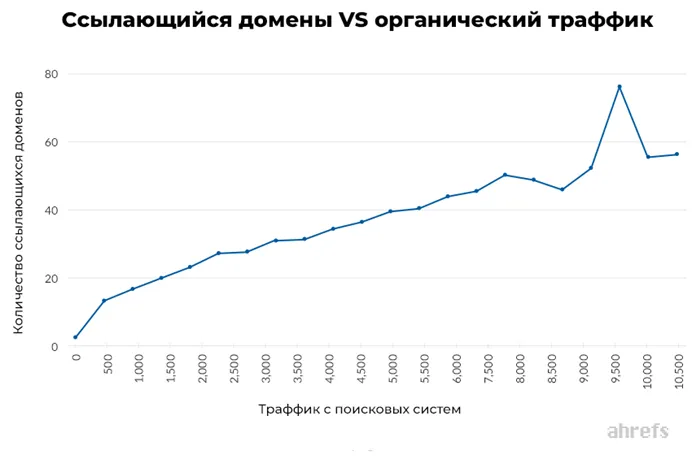

Для выполнения вышеуказанных действий Валерию необходимо 10 минут. Однако если вы тратите на поиск 10 минут в день, то это уже 5 часов в месяц. Вместо этого задача может включать программу, которая отслеживает появление новых элементов по расписанию. Что касается механизма действия, то это простой паук, нормализованный для выполнения определенных функций. Ни одна поисковая система не может выжить без краулеров, будь то лидеры рынка Google и Yandex или стартапы. Боты бродят по сети в поисках сырья для поисковой системы. Чем дольше работает паук, тем релевантнее результаты (Рисунок 1).

Функции паукообразных

В зависимости от поисковой системы, перечисленные ниже функции могут выполняться одним или несколькими ботами.

1. сканирование содержимого веб-сайта. Задача краулера первого порядка — обнаружить вновь созданные страницы и собрать опубликованную текстовую информацию.

2. сканирование графики. Если поисковая система включает поиск графических файлов, для этой цели можно использовать отдельный веб-паук.

3. зеркальное сканирование. Робот находит ресурсы, идентичные по содержанию, но разные по адресу. У «Яндекса» есть «работник» с такими возможностями.

Содержание

Поисковые системы имеют несколько пауков, каждый из которых поддерживает запрограммированную функцию (Рисунок 2).

Пауки «Яндекс»

- Яндекс/1.01.001 (совместимо; Win16; I) — центральный поисковый продукт Яндекса, индексирующий контент.

- Яндекс/1.01.001 (совместимо; Win16; P) — это робот, который индексирует изображения и фотографии.

- Яндекс/1.01.001 (совместимо; Win16; H) — находит зеркала и дубликаты ресурсов.

- Яндекс/1.03.003 (совместимо; Win16; D) — первый паук, который обращается к ресурсу после его добавления вебмастером. Его задача — проверить дополнительные параметры, указанные в таблице, на согласованность.

- Yandex/1.03.000 (совместимо; Win16; M) — краулер, который посещает страницу после загрузки ссылки «Слова найдены» в результатах поиска.

- YaDirectBot/1.0 (compatible; Win16; I) — индексирует страницы из рекламной сети Яндекса (RSS).

- Яндекс/1.02.000 (совместимо; Win16; F) — бот сканирует фавиконы сайтов.