Одним из самых популярных инструментов, используемых для этой цели, является Screaming Frog SEO Log File Analyser. Следует отметить, что программа не является бесплатной. Лицензия стоит 100 долларов США в год. Существует также бесплатная версия с ограниченной функциональностью:

Краулеры (поисковые роботы): зачем нужны, виды, как управлять и анализировать?

Краулер (поисковый робот, робот, паук) — это программа, являющаяся неотъемлемой частью поисковой системы и отвечающая за просмотр веб-сайтов и сканирование их содержимого, нажатие на страницы и ссылки для импорта собранной информации в базу данных поисковой системы.

Допустим, есть пользователь Иван Иванов, который каждый день посещает популярный книжный интернет-ресурс, который регулярно пополняется новыми наименованиями. Зайдя на сайт, Иван выполняет следующую последовательность действий:

- Заходит на главную страницу.

- Переходит в раздел «Новые книги».

- Просматривает список с недавно добавленными материалами.

- Открывает ссылки с заинтересовавшими его заголовками.

- Ознакомляется с аннотациями и скачивает интересующие его файлы.

Иванову потребовалось около 10 минут, чтобы найти подходящий материал. Если каждый день он будет тратить 10 минут на поиск нужной ему книги, то в общей сложности это займет у него 5 часов в месяц. И это только для одного сайта.

Чтобы избежать этих затрат времени, следует использовать программу, которая автоматически ищет новые книги.

Без роботов ни одна поисковая система не была бы эффективной, будь то Google или новая поисковая система. И чтобы избежать той же участи, что и Иван, они используют роботов, которые «ползают» по сайтам в поисках новой информации, которую поисковые системы предлагают пользователям. И чем лучше краулер сканирует, тем релевантнее контент в результатах.

Основные боты имеют следующие функции:

- Собирают новый или обновленный контент с веб-ресурсов. Сканированием свежих публикаций и ранее размещенных статей занимаются пауки первого порядка.

- Идентификация зеркал. Краулер отыскивает сайты, содержащие идентичный контент, но с разными доменами. Подобные боты имеет Яндекс.

- Сканирование графических файлов. Для поиска графики может быть привлечен отдельный робот.

И много других различных краулеров, имеющих свое собственное назначение, о которых мы поговорим ниже.

Виды краулеров

Каждая поисковая система имеет свои собственные веб-краулеры, которые выполняют различные задачи. Давайте поговорим о ботах двух самых популярных поисковых систем.

Роботы Яндекса

- YandexBot – основной краулер, занимающийся индексацией.

- YandexImages – вносит в индекс изображения ресурсов.

- YandexMobileBot – собирает страницы для их анализа и определения адаптации для смартфонов.

- YandexDirect – сканирует данные о материалах ресурсов-партнером РСЯ.

- YandexMetrika – поисковый паук сервиса Яндекс.Метрика.

- YandexMarket – бот Яндекс.Маркета.

- YandexCalenda – краулер Яндекс.Календаря.

- YandexNews – индексирует Яндекс.Новости.

- YandexScreenshotBot – делает скриншоты документов.

- YandexMedia – индексатор мультимедийных данных.

- YandexVideoParser – робот Яндекс.Видео.

- YandexPagechecker – отображает микроразметку.

- YandexOntoDBAPI – паук объектного ответа, который скачивает изменяющиеся данные.

- YandexAccessibilityBot – скачивает документы и проверяет, имеют ли к ним доступ пользователи.

- YandexSearchShop – скачивает файлы формата Yandex Market Language, которые относятся к каталогам товаров.

- YaDirectFetcher – собирает страницы, содержащие рекламу, с целью проверки их доступности для пользователей и анализа тематики.

- YandexirectDyn – создает динамические баннеры.

Боты Google

- Googlebot – главный индексатор контента страниц не только для ПК, но и адаптированных под мобильные устройства.

- AdsBot-Google – анализирует рекламу и оценивает ее качество на страницах, оптимизированных под ПК.

- AdsBot-Google-Mobile – выполняет аналогичные функции, что и предыдущий, только предназначен для мобильных страниц.

- AdsBot-Google-Mobile-Apps – работает также, как и стандартный AdsBot, но оценивает рекламу в приложениях, предназначенных для устройств на базе операционной системы Android.

- Mediaparnters-Google – краулер маркетинговой сети Google AdSense.

- APIs-Google – юзер-агент пользователя APIs-Google для отправки пуш-уведомлений.

- Googlebot-Video – вносит в индекс видеофайлы, содержащиеся на страницах ресурсов.

- Googlebot-Image – индексатор изображений.

- Googlebot-News – сканирует страницы с новостями и добавляет их в Google Новости.

Другие поисковые роботы

Гусеницы есть не только у поисковых систем. В популярной социальной сети Facebook, например, есть боты, которые сканируют страницы, размещенные пользователями, и отображают ссылки с заголовками, описаниями и изображениями. Давайте подробнее рассмотрим веб-пауков за пределами Google и Yandex.

Ahrefs

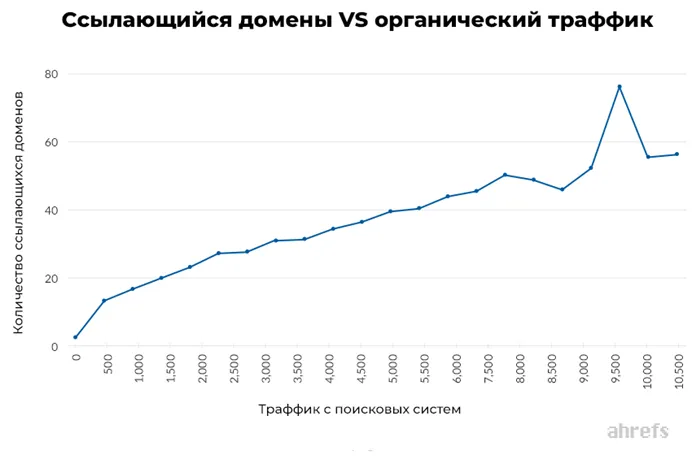

Самый популярный инструмент для SEO-продвижения, который помогает анализировать массу ссылок. Что он делает:

- изучает обратные ссылки;

- проводит мониторинг конкурентов;

- анализирует ранжирование;

- проверяет сайты, недействительные ссылки;

- изучает ключевые слова, фразы и многое другое.

Как управлять поисковым роботом?

Часто бывает так, что доступ к определенным страницам сайта должен быть ограничен для определенных краулеров. Для этого существуют специальные правила, которые веб-мастера предписывают паукам соблюдать. Они указываются в файле robots.txt.

Попав на сайт, роботы сначала сканируют информацию в файле со списком документов, которые не подлежат индексации, например, личные данные зарегистрированных пользователей. Прочитав правила, краулер либо покидает сайт, либо начинает индексировать ресурс.

Что назначать

- разделы сайта или фрагменты контента, закрытых/открытых для пауков;

- интервалы между запросами роботов.

Единственный выход из этой ситуации — написать собственный сценарий для сканирования, сбора, хранения и систематизации важной информации. Но как это сделать? Дочитайте до конца, и вы увидите, что все очень просто!

По сути, это робот, который работает по принципу роботов, индексирующих сайты для поисковых систем. Принцип работы очень прост: он ищет в коде страницы нужную информацию, извлекает ее и сохраняет в структурированном виде в виде списка, таблицы или базы данных.

Представьте, что Сергею Брину однажды помешали основать Google. Без поисковой системы вы никогда не смогли бы быстро найти в Интернете рецепт любимого блюда, информацию о написании курсовой работы или что-нибудь еще. Поэтому логический вывод таков: поисковые системы - те же краулеры, но разработанные в виде самого простого, понятного и удобного инструмента.Автографические анализаторы, работающие по тому же принципу, позволяют:

- Страница about.html закрыта от всех краулеров.

- Роботам твиттера разрешено смотреть сайты, в адресе которых содержится /images .

- Остальным поисковым паукам разрешено посещать страницы, которые заканчиваются на /images, но глубже переходить нельзя ( Dissallow: /images/* ).

Как написать краулер? Туториал для новичков!

Главная>Блог>Business>И это лишь малая часть возможностей, которые открывает использование анализатора.

Существует два способа сканирования веб-сайтов для поиска и хранения нужной информации:

Один из вариантов для людей, знающих основы программирования. Самописный скрипт характеризуется тем, что его функциональность определяете вы. И вы можете настроить бота для любой задачи: от отслеживания цен до сбора базы данных поставщиков.

Что такое Web Crawler?

Чаще всего трекеры пишутся на языке Python. Сам сценарий состоит из трех частей:

Но почему именно Python? В конце концов, разве тот же JavaScript или PHP намного проще в изучении и может обеспечить такую же функциональность? Речь идет о библиотеках, которые гораздо эффективнее осуществляют поиск информации по заданным параметрам.

Однако из-за высокого входного порога написание первого парсера на Python может занять много времени. А если вы не хотите утруждать себя основами программирования, то обратите внимание на второй способ очистки данных.

- Собирать информацию по заданной теме из различных ресурсов с одного или нескольких сайтов;

- Анализировать настроения аудитории посредством сбора отзывов о различных товарах или услугах;

- Сформировать базу данных с адресами, контактами магазинов для выявления новых рынков сбыта продукции вашей компании.

Все дело в использовании преимуществ существующих инструментов парсинга. Вы также можете создать сканер для своих нужд. Для этого:

Создание веб-краулера

Вам не нужно исправлять ошибки или беспокоиться о настройке «правильной» скорости сканирования — все это включено «по умолчанию» в предварительно созданные анализаторы.

Парсинг с помощью языков программирования

- Направление запроса по URL-адресу страницы с последующим возвращением её содержимого;

- Генерирование древовидной структуры на основе полученного HTML-кода со сканированием по заданным веткам;

- Синтаксический анализ полученной информации через библиотеки Python для выделения нужных вам фрагментов.

Готовый парсер

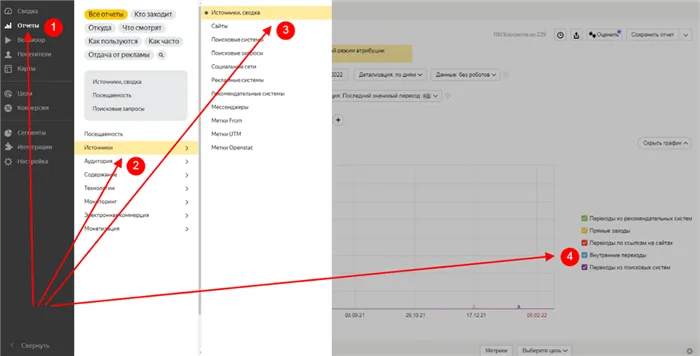

- Переходим в режим «Расширенных настроек»;

- Создаем новую задачу, вводим адрес сайта;

- «Разбиваем» страницу, выделяя нужные нам пункты;

- Зацикливаем процесс, начинаем извлечение данных.