Спасибо за статью, Александр! Чуть больше года назад у меня была ситуация, когда ACS поразил меня. Ничего, я справился! Я исправил ошибки, и все было восстановлено. Вот статья с подробным рассказом (возможно, кому-то она будет полезна!): _http://teweb.ru/kak-vyiyti-iz-pod-filtra-yandeks-ags/

Вывод сайта из-под фильтра. Пошаговое руководство

Вывод сайта из-под фильтра — это ряд действий, направленных на исправление ошибок, допущенных при SEO-оптимизации сайта. Иногда, когда возникает желание быстрого роста сайта, его владелец прибегает к запрещенным методам SEO-оптимизации. В результате ресурс попадает под фильтр: страницы удаляются из индекса, позиции резко падают, а трафик убывает на глазах. Но не сдавайтесь, ведь выход сайта из фильтров Google или Yandex (Минусинск, Баден-Баден, AGS и другие) хоть и сложен, но выполним.

- Сообщения с предупреждениями в сервисах «Яндекс.Вебмастер» и Google Webmasters.

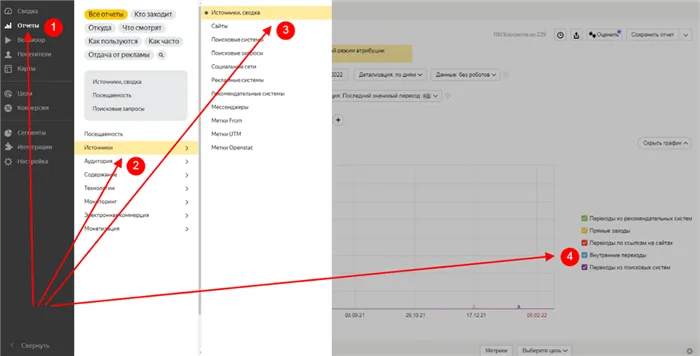

- Мониторинг посещаемости в сервисах аналитики Google Analytics и «Яндекс.Метрика». Отмечается резкий спад трафика.

- Использование online-инструментов и программ (xtool.ru, pr-cy.ru, Panguin Tool, Website Penalty Indicator, Google Penalty Checker и другие).

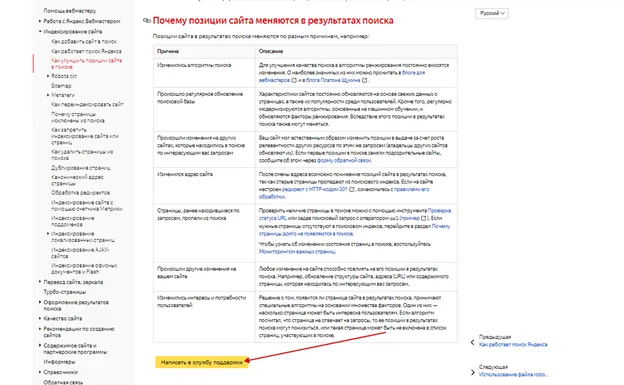

- Написать «Яндексу». Представители поисковой системы ответят, что случилось с вашим сайтом и даже могут указать на конкретные страницы из-за которых пострадал сайт.

Причины попадания сайта под фильтр

Первое, что необходимо сделать, — определить причину возникновения фильтра. Наиболее распространенные ошибки:

- переоптимизация страниц ключевыми словами (материалы не для людей, а для поисковых роботов);

- неуникальные тексты (частично или полностью скопированные);

- много дублей внутри сайта;

- медленная загрузка или частая недоступность ресурса;

- большое количество исходящих ссылок, не соответствующих рекомендациям поисковых систем;

- плохое качество входящих ссылок;

- вирусные атаки.

Как выйти из-под фильтра «Яндекса» и Google

Проверьте, не находится ли ваш сайт под ручными санкциями. Чтобы узнать это, воспользуйтесь службой Google для веб-мастеров:

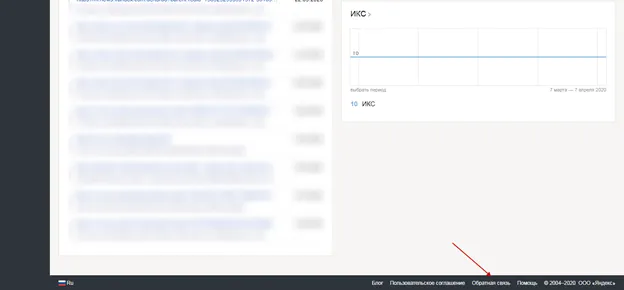

Также узнайте о возможных проблемах в Яндекс.Вебмастере:

Если вы не найдете причину, это означает, что ваш сайт был автоматически затронут при просмотре поисковой системой. Соответственно, можно также автоматически оставить фильтр и устранить все проблемы.

Как снять фильтр поисковой системы? Пошаговое руководство:

1. Избавьтесь от дублированного контента

Дублирование контента на сайте — одна из самых распространенных причин отказа поисковых систем от выдачи ссылок.

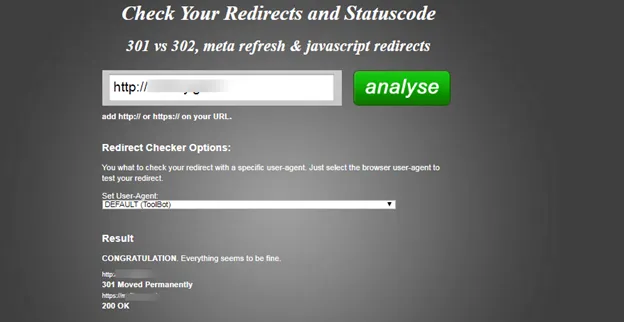

Проверьте, по какому адресу открывается ваш сайт, если 301 редирект настроен правильно. Новички часто забывают указать правильную версию сайта для робота, что приводит к тому, что сайт индексируется как в WWW-, так и в не WWW-версии.

То же самое относится к протоколам http и https. Для анализа можно использовать сайт Redirect-checker.org:

Кроме того, дублирующим контентом может быть текст, который присутствует на всех страницах. Лучше всего исключить его из индексации, включив в соответствующий файл Robots.txt, который исключает из индексации нежелательные страницы.

Хорошо, если ваш ресурс состоит из множества статистических страниц на чистом HTML, так как они с меньшей вероятностью будут отфильтрованы поисковыми системами по сравнению с генерируемыми (динамическими) страницами.

2. «Юзабилити» или удобство сайта для пользователей

При необходимости следует переработать структуру и внешний вид веб-сайта. Такие меры непросты, но часто для удаления фильтра без них не обойтись. Посмотрите на свой сайт с точки зрения пользователя и измените все недостатки.

Важно, чтобы посетители интуитивно понимали, как ориентироваться на вашем сайте, чтобы добраться до места назначения. Ничто не должно мешать.

3. Внешняя SEO-оптимизация

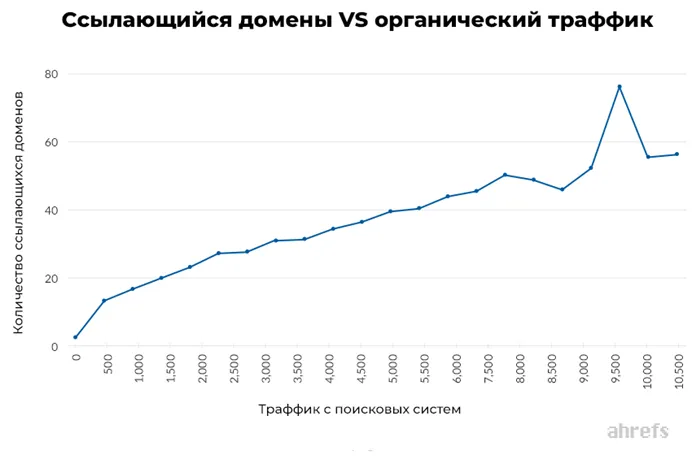

Ссылки по-прежнему успешно используются веб-мастерами для продвижения сайтов. Поисковые системы пересмотрели их значение в алгоритмах ранжирования, но они по-прежнему эффективны. Но подход к построению ссылок для многих не изменился.

Избегайте спамных постов и выбирайте только высококачественных «доноров» с хорошими показателями и безупречной репутацией. В противном случае это может повлиять на развитие проекта.

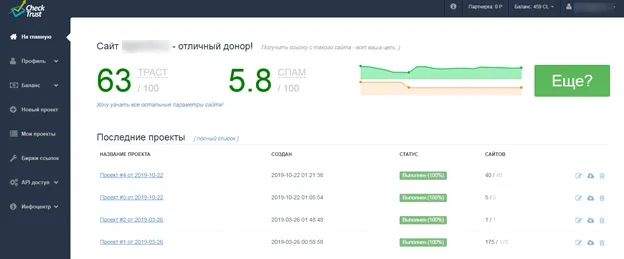

Ссылки с надежных сайтов также могут помочь вам обойти фильтр. Отбор высококачественных «доноров

В редких случаях причиной зелья является плохое гостеприимство. Если ваш сайт часто недоступен из-за ошибок хостинга, рано или поздно такие ошибки приведут к штрафным санкциям: Потеря позиций или удаление страниц из индекса.

4. Смена хостинга

Если сайт попадает в фильтр, его страницы удаляются из индекса, позиции в SERP падают, трафик резко снижается, и все мечты о быстрой прибыльности тают на глазах. Но не отчаивайтесь, как уже говорилось выше, оно того не стоит. Есть возможность вывести свой сайт из-под фильтра. И обычно это не так сложно, как кажется на первый взгляд.

Как выйти из под фильтра Яндекса

Сначала попробуйте понять, почему сайт фильтруется Яндексом. Причин отсутствия индексации может быть много, но наиболее важными являются следующие:

Основные причины попадания под фильтр Яндекса

Частая недоступность сайта для посетителей и поисковых систем, медленная работа (долгая загрузка страниц, что приводит к частым «сбоям»), также не лучший результат при индексации.

- частично или полностью копированный текст с других источников(ссылки на первоисточник не всегда считаются или вообще не беруться в расчет);

- большое количество внешних ссылок(заспамленность);

- много дублированных страниц внутри сайта;

- большая часть текстов написаны для поисковиков, а не для людей.

Если вы очень постараетесь, сайт восстановит свои позиции, поскольку фильтр накладывается автоматически и, следовательно, удаляется также в автоматическом режиме. Мы рассмотрим некоторые способы удаления фильтра с сайта, но сначала вам нужно решить, не проще ли будет создать новый сайт в новом домене.

Как выйти из под фильтра Яндекса

Например, если сайту менее шести месяцев, вы не потеряете много. Возможно, за это время у вас появится идея для другого, более красивого и соответствующего релевантности домена. Тогда все признаки указывают на то, что вам необходимо создать новый сайт.

Если после размышлений у вас все еще остается вопрос: «как выйти из-под фильтра Яндекса», то:

1. сначала необходимо закрыть все копии на сайте. Прежде всего, следует удалить все копии всех копий.

Дублированный контент — это самая распространенная причина, можно сказать, всех штрафов поисковых систем!

Одна и та же страница может быть проиндексирована с WWW и без, т.е. уже в дубликате. Там может быть много дубликатов и всевозможных вариантов, от которых нужно избавиться. Скопированный текст, но необходимый читателям для исключения из индексации специальным тегом -.

заблокированный текстЛучше всего, если на сайте будет большое количество статических страниц и как можно меньше генерируемых страниц. Согласно статистике, сайты, написанные на чистом HTML, гораздо реже фильтруются поисковыми системами, чем сайты с динамическим контентом.

2. вам придется изменить структуру сайта, адаптировать дизайн и т.д. Этот процесс сложен для новичков. Стоит отметить, что в настоящее время популярными системами WordPres являются

Ключевые слова: рентген, рентген услуги, рентген услуги, рентген в Москве, цены на рентген

Именно поэтому текст был изменен:

Как выбрать валютную пару для Форекс-трейдинга?

Плюсы и минусы видеоблогинга

Второе направление – правильно оптимизировать

Что же делать, если вы попали в фильтр и еще ничего не трогали?

- изменили метаданные;

- переписали тексты на уникальные, поменяли структуру заголовков (прежде всего на страницах, которые приносили больше всего трафика).

1. полностью отказаться от использования сервисов, которые Яндекс упоминает в письме о фильтре.

Пример электронного письма, полученного при подтверждении фильтра:

Скорее всего, причиной изменения позиций вашего сайта стало, например, использование некорректных методов поисковой рекламы (https://company.yandex.ru/rules/optimization 2):

— Моделирование действий пользователей поисковых систем (https://webmaster.ya.ru/replies.xml?item_no=10399 3),

— массовое использование SEO-ссылок (https://webmaster.ya.ru/replies.xml?item_no=325 4).

Что делать? Краткая инструкция

Вполне вероятно, что для продвижения вашего сайта использовались сервисы или программы, использующие подобные методы. Такие как Userator, Movebo, WebEffector, SerpClick, Seopult и др. Возможно, это было сделано компанией, предоставляющей услуги по поисковому продвижению вашего сайта. Избегая ложных методов продвижения и оптимизируя свой сайт в интересах пользователей, вы сможете вернуть доверие поисковых систем и занять достойное место в рейтинге.

Если вы не изменяете, но пользуетесь одним из вышеперечисленных или подобных сервисов, вам определенно следует отказаться от их использования.

2. ищите ключевые слова во внутренней ссылке, тексте или метатегах.

Если вы заметили хотя бы один из этих признаков, вам следует избавиться от спама, потому что он может быть одной из причин пессимизма, даже если вы вообще не рассылали никакого спама. Мы не можем сказать наверняка, как работает фильтр, но опыт выхода из-под него подсказывает, что это вполне возможно.

Помните об этом. Начните со страниц, которые приносят наибольший трафик. Если у вас, скажем, 300 страниц, и 10 страниц приносят 90% трафика, этот случай показывает, что может быть достаточно работать над этими страницами.

3. провести правильную оптимизацию.

Пересмотрите структуру текстов, сделайте их уникальными, установите правильные метатеги.

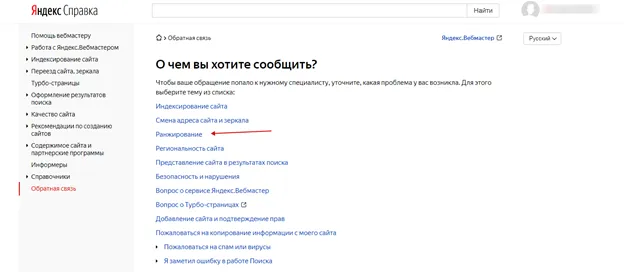

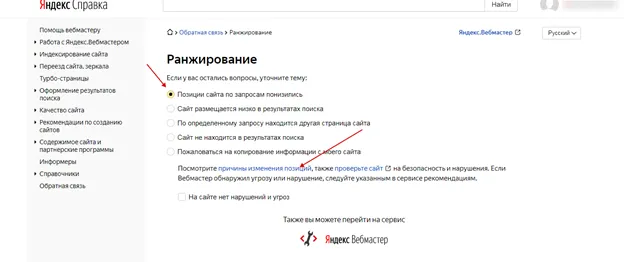

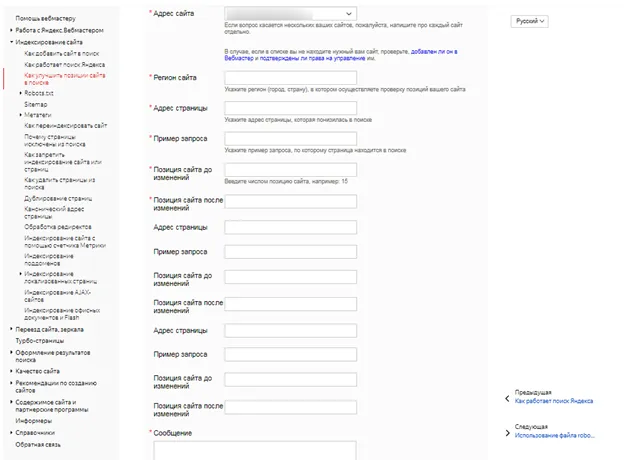

4. постоянная переписка с технической поддержкой Яндекса.

Это одно из самых важных требований — постоянно переписывайтесь во время работы, показывайте, что это очень важно для вас.

Ниже приведен пример нашей переписки в ее первоначальном виде. Вы можете использовать его как шпаргалку.

Здравствуйте, уважаемая служба поддержки Яндекса!

В соответствии с вашими рекомендациями мы проанализировали наш сайт и устранили все признаки того, что сайт продвигается не должным образом. Мы понимаем, что фильтр накладывается и снимается автоматически, поэтому мы хотели бы знать, соответствует ли сайт всем рекомендациям Яндекса.

Как мы можем быть уверены, что в следующем обзоре сайт будет оценен положительно? Возможно ли, что участок будет рассмотрен раньше, если он соответствует всем требованиям?

Заранее большое спасибо!

Здравствуйте!

Любые подробности о том, как

Я периодически публиковал там статьи, но только для того, чтобы создать видимость жизни. В статьях не было фотографий, только анализ, состоящий из абзацев, а качество статей было поверхностным (хотя и уникальным и своевременным).

Короче говоря, живые люди мало кого интересовали.

Поскольку вся функция сайта заключалась в главной странице, которая содержала запись о рассылке новостей, все остальные разделы были скрыты, и единственная ссылка на них находилась на главной странице.

Все статьи были опубликованы только в 2 разделах — бизнес и обзоры (продажи).

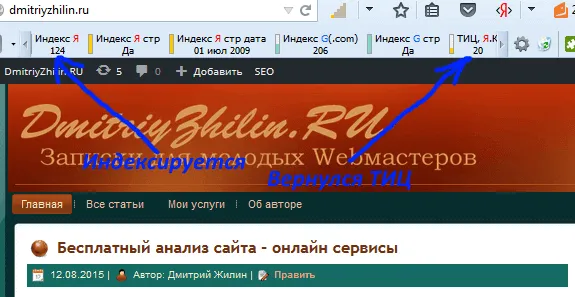

Поскольку сайт имел позомерки (ТИЦ = 20 и PR = 2), я использовал его для заработка — размещал статьи с вечными ссылками biznessystem.ru/miralinks/. Хотя ссылок на сайте было не много, но в процентном соотношении к количеству страниц было много.

Кроме того, на сайте были баннеры с постоянными ссылками на мой основной блог, и многие статьи содержали ссылки на него.

Не было файла Robots.txt (чувствительного к WordPress), поэтому страницы с дублированным контентом не были заблокированы для индексации. Главное зеркало сайта не было указано.

Почему мой сайт попал под фильтр

Почти на всех страницах не были заполнены метаданные title и description. У меня не было намерения продвигать их, поэтому я вообще не занимался этим вопросом.

Те, которые были в моей власти (на моих собственных сайтах), я немедленно удалил. С вечными ссылками от Miralinks было сложнее, потому что вы не можете удалить их без разрешения оптимизаторов. Не все из них удалось удалить, но некоторые исчезли. Вот что я сделал:

Я постарался максимально очистить существующие статьи — добавил к ним изображения. Это делается в выделенных списках, которые имеют подзаголовки h2, h3.

Название и описание всех статей были исправлены.

В общем, все сделал так, как рекомендовано в его же посте «Как правильно писать статьи, как Яндекс.Директ».

Он создал заголовки профилей и разместил все статьи в соответствующих разделах.

Он изменил главную страницу со статической на стандартную ленту блога.

У меня есть боковая панель с заголовками, списками файлов и недавними сообщениями.

Добавлена страница автора.

Добавлена карта сайта с помощью WP DS Blog Map.

Как я выводил сайт из под АГС

Создал robots.txt, создал сайт без www как главное зеркало, скопировал путь к файлу sitemap.xml (карта сайта для поисковых систем). Я сделал все по правилам, описанным в моей статье «Правильный Robots.txt для WordPress».

- Проверил на работоспособность все ссылки. Часть оказались уже не рабочими – через администрацию биржи получил разрешение на их удаление.

- Написал всем оптимизаторам письмо со словами «Мой сайт под АГС, пользы вам никакой (может даже вред), разрешите снять статьи». Несколько рекламодателей дали добро, так я избавился еще от нескольких ссылок.

- Оформление контента

Используя плагин All in One SEO Pack, я исключил из индексации все дублирующиеся разделы.

Я начал регулярно публиковать новые посты. Добавлено около 20 статей среднего уровня. Не очень, но достаточно для нормального блога — с картинками,

Все санкции были сняты. ТИЦ был немедленно введен в эксплуатацию, и с каждым новым обновлением поисковой базы данных в индекс добавлялись новые элементы. В настоящее время почти все записи проиндексированы, и даже есть некоторый трафик.

Одно могу сказать — фильтр AGS не так ужасен, как пишут на многих форумах, и избавить сайт от него несложно. Этого достаточно, чтобы сделать паршивый сайт для людей.

Если вам нужен совет по конкретному проекту, спросите меня, я постараюсь вам помочь, так как у меня уже есть опыт.

У меня нет ничего из того, что вы описали — все статьи с фотографиями, скриншотами и личными видео. Заголовки от H1 до H4. Я не покупал никаких ссылок. Статьи регулярно индексируются и находятся в поиске, а также до сих пор хранятся в AGS. Страниц в поиске 132 — так показывает Яндекс.Вебмастер. Мне не хочется писать Платону…….

Я просмотрел ваш блог. Я не нашел никакой причины, которая могла бы быть причиной работы фильтра. На вашем месте я бы уже давно написал письмо Платону. Только сразу напишите, что вы прочитали все требования Яндекса к сайтам (приведите ссылки на помощь Яндекса), но не нашли ни одной причины, по которой сайт находится под АГС.

Здравствуйте: Страницы в Яндексе 1, проверил АГС Нет. Не понимаю почему страницы удаляются из индекса? Может быть, они находятся в robots.txt или sitemap?

Сайт у вас довольно молодой робот Яндекса не привык к регулярным посещениям его. На этом этапе вам следует анонсировать больше постов в различных социальных сервисах и на других сайтах (например, подписка). Подробнее об ускорении индексации здесь. В файле robots есть ошибки — между разделами есть пустые строки — каждый агент пользователя должен быть в отдельном блоке (пустые строки до и после) — это может привести к недоразумениям с политикой sitemap. Кстати, у вас в sitemap есть страницы с тегами, которые не разрешены в robots.txt — лучше привести их к общему знаменателю. Подробнее о создании robots.txt для WordPress я писал здесь. В целом, я не думаю, что причина в robots.txt, скорее всего, сказывается молодость сайта — воспользуйтесь советами по ускорению индексации и ждите.

Спасибо, сталкивались ли вы с ошибками разметки Microdata? Конкретно отсутствует: Автор отсутствует: Обновлено

Я так и делал, но никогда не сталкивался с фильтром, потому что наценка была слишком высокой. До сих пор поисковые системы рассматривали микроразметку как глазурь на торте (необязательное дополнение).

В этом разделе перечислены наиболее распространенные нарушения и фильтры Яндекса и описано, как вывести сайт из-под каждого фильтра.

Бесполезный (неоригинальный) контент — фильтр «Малополезный»

Результаты

SEO-тексты — распознаются фильтром Баден-Баден. Сюда относятся гипер-оптимизированные (с большим количеством ключевых слов) материалы, написанные для поисковых систем, а не для людей. Мы переписываем текст, «размываем» ключевые слова и делаем материал интересным для целевой аудитории.

Агрессивная реклама — также означает снижение позиции сайта в публикации. Никому не нравятся рекламные баннеры, которые заслоняют содержание сайта. Сократите размер рекламных блоков до рекомендуемых 10% от общего пространства экрана.

Мошенничество с поведенческими факторами — это имитация действий заинтересованного посетителя. Блокировки сайтов Яндексом по этой причине были распространены в 2018 году из-за обильной рекламы «нового» метода быстрой рекламы. Перестаньте подстраивать поведенческие факторы, когда вы их используете. Помните, что в нашей практике были случаи, когда сайт попадал под этот фильтр из-за действий конкурентов.

Предупреждение. Мы советуем вам НЕ покупать и не использовать скрипты, программы или услуги, которые имитируют действия «живого» человека на сайте — не попадайтесь в ловушку быстрого «снятия» сайта.

Статьи из этой же рубрики:

- Зачем пузомерки вашему сайту?

- Что такое непот фильтр и как его избежать?

- Что лучше: РСЯ или Adsense — результаты эксперимента

- Эксперимент с Google Adsense №2. Яркость или дизайн?

- Сколько я заработал в сервисе Блогун? (Итоги эксперимента)

- Тошнота текста — онлайн сервисы для проверки

- Как добавить сайт в Яндекс Вебмастер, пошаговая инструкция по настройке

16 комментариев на «“Как я вывел сайт из под АГС фильтра Яндекса”»

Опасные веб-сайты — характеризуются наличием вредоносного или вирусного кода. Как и в предыдущем случае, доступ к сайту блокируется, поэтому мы советуем вам удалить этот код как можно скорее. Возможно, вам придется использовать антивирусное программное обеспечение или восстановить сайт из архива. Поэтому еженедельно создавайте архивные версии сайтов, чтобы в случае заражения можно было быстро восстановить сайт и сменить все пароли.

Аффилиат-фильтрация — для подстраховки аффилированных сайтов, т.е. дополнительных сайтов от того же владельца или компании, предоставляющих примерно ту же информацию. Только одна страница вашего бизнеса будет отображаться в результатах. Таким образом, Яндекс борется с монополизацией результатов поиска и предлагает наиболее разнообразный контент, релевантный поисковому запросу. Однако возможно продвижение нескольких страниц «Like», свяжитесь с нами для получения дополнительной информации.

Устранили ли вы нарушение? Нажмите кнопку «Я исправил» в Яндекс.Вебмастере и наберитесь терпения. Яндекс не указывает сроки удаления фильтров. В нашей практике удаление фильтра может занять от месяца до года.

Алгоритмы поисковых систем постоянно совершенствуются, но их нельзя назвать идеальными. Существуют способы обойти их и вывести сайт в топ в течение нескольких дней. Техники черного SEO основаны на трех принципах:

Результатом является быстрый «захват» вверху и столь же быстрое блокирование сайта, так как он так же быстро обнаруживается поисковыми системами. Краткосрочный эффект делает бессмысленным продвижение большинства нишевых сайтов с помощью методов SEO из черного списка. В некоторых популярных нишах, однако, риск оправдан — «сайт-однодневка» успевает набрать посетителей. Давайте поговорим о наиболее распространенных рекламных методах такого рода.

Невидимый для пользователя текст — классический пример черной рекламы. Цвет текста и цвет фона одинаковы, а содержание представляет собой огромный набор ключевых слов. Яндекс очень точно определяет видимые и скрытые области сайта на основе HTML-кода и поведения пользователей. Блокировка сайта гарантирована.

Под каким фильтром сайт? Как вывести сайта из-под фильтра Яндекса

Скрытие (или сокрытие контента) — это разделение контента для ползунков поисковых систем и для посетителей. Чаще всего боты поисковых систем открывают сайт dorway (описание ниже), а пользователи получают контент с другого сайта, на который направлен трафик.

Дорвебы — это сайты, специально разработанные и оптимизированные под определенный поисковый запрос или группу поисковых запросов для перенаправления посетителей на другой основной ресурс. Это могут быть одностраничные сайты или полноценные сайты.

Линк-фермерство или сателлитное фермерство — это создание нескольких сайтов-сателлитов с перекрестными ссылками и ссылками на основной сайт. Необходимо создать несколько хороших сайтов с актуальным контентом, чтобы в результате применения появилась масса ссылок и укрепились позиции основного сайта. Однако, если фильтры поймают один сайт, он будет «обучен» и потянет за собой в бан все остальные.

Покупка ссылок на биржах и «прогон» в каталогах — метод, позволяющий получить массу ссылок, которые Яндекс определяет как рыночные и низкокачественные, что почти всегда приводит к злоупотреблению ссылочным профилем и неизбежному бану сайта.

Внимание: не ведитесь на объявления, обещающие автоматическое размещение в 100500 каталогах, или массовые сообщения на форумах и блогах — вы нанесете непоправимый ущерб своей репутации как владельца домена.

Использование методов черного рынка всегда приводит к тому, что сайт блокируется, а последствия трудно исправить. Иногда единственным вариантом является изменение доменного имени.

Мы рекомендуем не использовать «черные» и «серые» методы SEO-продвижения. Выбирайте SEO с умом и не верьте в быстрые результаты в SEO — они могут быть достигнуты только запрещенными методами.

Когда сайт проходит фильтрацию, у вас часто есть только один шанс сделать все правильно. Повторные нарушения приведут к бану на длительный период времени, после чего единственным вариантом обычно является смена домена.

Работа по выведению сайта из-под фильтра требует знаний, поэтому мы рекомендуем обратиться к профессионалу, имеющему практический опыт устранения причин запретов. Наша компания также предлагает услугу по устранению щелей под фильтром. Пишите свои вопросы в комментариях или звоните — мы вам поможем!

Чёрное-пречёрное SEO: срочно прекратите ЭТО делать

- использование уязвимости алгоритмов позволяет быстро подняться в топ;

- высокопопулярные ниши для большого поискового трафика;

- высокая степень автоматизации — позволяет быстро создавать и выводить новые сайты в топ взамен забаненных;

А может не заниматься «самолечением»?