В нашей компании самоопределение является частью рабочего процесса многих разработчиков. Такая практика более характерна для стартапов и редко встречается в средних и крупных компаниях. Почему? У меня сложилось впечатление, что решение полностью передать разработку специалистам, играющим роль релиз-инженеров, было принято по очевидным причинам:

10 антипаттернов деплоя в Kubernetes: распространенные практики, для которых есть другие решения

Когда контейнеры используются в производстве, производственная среда должна оставаться стабильной и отказоустойчивой. Если один из контейнеров ломается, всегда нужно иметь другой работающий, чтобы заменить его.

Kubernetes предоставляет платформу для отказоустойчивых распределенных систем, от масштабирования до устранения сбоев и балансировки нагрузки. В Kubernetes встроено множество инструментов, которые помогут вам в этом.

Перевод статьи о десяти распространенных практиках развертывания Kubernetes, для которых существуют другие решения. Автор не вдается в подробности практик, поскольку их применение может отличаться у разных пользователей.

Размещение файлов конфигурации внутри/рядом с образом Docker

Этот антишаблон Kubernetes связан с антишаблоном Docker (см. антишаблоны 5 и 8 в этой статье). Контейнеры позволяют разработчикам использовать единое представление на протяжении всего жизненного цикла программного обеспечения, от разработки/контроля качества до предпроизводственной подготовки, разработки и производства.

Однако общепринятой практикой является предоставление каждой фазе жизненного цикла собственного образа, созданного с помощью различных артефактов, специфичных для данной среды: Контроль качества, фаза или производство. Но тогда вы больше не разрабатываете то, что только что протестировали.

Рекомендуется хранить общие настройки в ConfigMaps, а конфиденциальную информацию (например, ключи и секреты API) можно хранить в ресурсе Secrets. Он закодирован в Base64, но в остальном работает так же, как и ConfigMaps.

ConfigMaps могут быть смонтированы как тома или переданы как переменные окружения, но Secrets должны быть смонтированы как тома. Я упоминаю ConfigMaps и Secrets, потому что они являются собственными ресурсами Kubernetes и не требуют интеграции, но у них есть свои ограничения.

Существуют и другие решения, например, ZooKeeper и Consul от HashiCorp для ConfigMaps или Vault, Keywhiz и Confidant от HashiCorp для секретов. Они могут лучше соответствовать вашим потребностям.

Если вы отделили конфигурацию от приложения, вам не нужно заново создавать приложение, когда вам нужно обновить конфигурацию. Его можно обновлять во время работы приложения. Ваши приложения настраиваются во время выполнения, а не во время создания. Самое главное — вы используете один и тот же исходный код на всех этапах жизненного цикла программного обеспечения.

Работа без Helm или других шаблонизаторов

Вы можете управлять разработкой в Kubernetes, обновляя YAML напрямую. Когда вы развертываете новую версию кода, вам, скорее всего, потребуется обновить один или несколько ресурсов:

- Имя образа Docker.

- Название изображения.

- Docker Docker Label Label Label.

- Количество меток Docker Docker.

- Стручки.

- ConfigMaps и так далее.

Этот процесс может быть утомительным, если вы управляете несколькими кластерами и применяете одни и те же обновления в средах разработки, тестирования и производства. По сути, вы изменяете одни и те же файлы с незначительными изменениями для всех ваших развертываний. Приходится много копировать и вставлять или искать и заменять, а также учитывать среду, для которой предназначена разработка YAML.

В этом процессе есть много места для ошибок:

- Типографские ошибки: неправильные номера изданий, неправильно написанные названия изображений и так далее.

- Изменение YAML с неверными данными, например, привязка к неверной базе данных.

- Нет ресурсов для обновления и т.д.

Вам может понадобиться изменить многие вещи в YAML, и если вы не будете осторожны, YAML одного разработчика может быть легко перепутан с YAML другого.

Шаблоны упрощают развертывание и управление приложениями Kubernetes. Поскольку Kubernetes не предоставляет собственный движок шаблонов, нам приходится искать сторонние менеджеры шаблонов.

Helm был первым доступным менеджером пакетов, представленным в 2015 году. Она называлась «Homebrew for Kubernetes» и была расширена возможностью создания шаблонов.

Helm упаковывает свои ресурсы с помощью диаграмм, где диаграмма — это набор файлов, описывающих связанный набор ресурсов Kubernetes. В репозитории диаграмм (вы также можете использовать флаги ключевых слов поискового узла Helm) имеется более 1400 общедоступных диаграмм, в основном это рецепты многократного использования для установки, обновления и удаления в Kubernetes.

Диаграммы Helm позволяют изменять файл values.yaml, чтобы указать изменения, необходимые для развертывания Kubernetes, и вы можете создавать различные диаграммы Helm для каждой среды. Таким образом, если у вас есть среда QA, промежуточная среда и производственная среда, вам нужно управлять только тремя диаграммами Helm вместо того, чтобы изменять каждый YAML в каждом развертывании в каждой среде.

Еще одним преимуществом Helm является то, что вы можете легко вернуться к предыдущей версии с помощью откатов Helm, если что-то пойдет не так:

Если вы хотите вернуться к более ранней версии, вы можете это сделать:

После этого вы увидите что-то вроде:

И история Хелма в чартах прекрасно это отражает:

Перевод статьи о десяти распространенных практиках развертывания Kubernetes, для которых существуют другие решения. Автор не вдается в подробности практик, поскольку их применение может отличаться у разных пользователей.

Deployment stages

Code delivery to the server

В зависимости от упаковки, существуют различные способы доставки кода на сервер. Иногда код подается непосредственно на сервер в виде файлов, но чаще он обновляется через Git. В прошлом метод разработки с помощью стандартных менеджеров пакетов дистрибутивов Linux был очень популярен. Он используется и сегодня, и лучше всего подходит для определенных ситуаций.

- Git: git checkout tag-name

- Docker: docker pull image-name:tag-name

- Apt (пакет): apt-install application-package-name

Database update

Обычно новая версия приложения требует внесения изменений в базу данных. Для этого во время (или до) разработки выполняются миграции — специальные скрипты, содержащие правила обновления баз данных. Например, сценарии SQL:

Start and stop

В какой-то момент этого процесса старая версия останавливается и начинается новая. Если мы сначала остановим старую версию, затем выполним миграцию и запустим новую версию, служба не будет работать. Для многих это обычное дело, но для компаний и частого развертывания это может оказаться сложной задачей. Поэтому передовые проекты не останавливаются во время разработки. Ниже вы найдете описание того, как это сделать.

Automation

Разработка должна быть максимально автоматизирована, поскольку от этого зависит время выхода на рынок, что является ключевой особенностью бизнес-ориентированных приложений. Чем быстрее и чаще мы будем доводить изменения до пользователей, тем лучше. Чем быстрее мы тестируем примеры, тем быстрее мы можем внедрять изменения и тем быстрее окупаются деньги, вложенные в разработку. Разработчики боятся заниматься разработкой без автоматизации, она становится обузой, что приводит к снижению количества внедрений и регулярному стрессу для всей команды, работающей долгие часы.

Существует три основных пути автоматизации:

- Использование утилит, разработанных для конкретных языков. Примером может служить Capistrano в Ruby, одна из первых и наиболее известных утилит такого рода, которая стала известна далеко за пределами Ruby. Основная проблема таких инструментов заключается в том, что они сильно привязаны к языку

- Использование Ansible с уже встроенным модулем для разработки. Это актуально для большинства ситуаций разработки на управляемых серверах

- Системы оркестровки типа Kubernetes: если используются, то без автоматизированной разработки не обойтись.

Однако даже если автоматизация проведена, задача «постоянного развития» остается. Ввод в эксплуатацию также автоматизирован. Существует целый подход под названием Continuous Delivery. Его трудно внедрить, и он не везде подходит, но когда он работает, вы можете забыть о разработке. Это происходит само по себе, без вмешательства человека. Самое главное в этом варианте — хорошая система мониторинга и оповещения.

Zero Downtime Deployment

Если не предпринять никаких специальных действий, служба будет останавливаться (возможно, частично) при каждом развертывании. В этот момент пользователи получат либо сообщение об ошибке, либо уведомление о том, что выполняется обновление. Однако в большинстве крупных интернет-сервисов дело обстоит иначе. Почему? Благодаря реализации подхода «Zero Downtime Deployment» (под «простоем» мы подразумеваем время простоя услуги).

Развертывание с нулевым временем простоя означает, что служба никогда не прекращает работу, но в это время обновляется. Это достигается путем одновременного запуска старой версии и нового кода. Это означает, что при развертывании приложения новая версия появляется рядом со старой. И только когда автоматика обеспечивает запуск и выполнение новой версии, старая версия останавливается. Для выполнения этого процесса необходимы следующие требования:

Он автоматически появился после фиксации, которая вызвала вебхук в Gitlab, а затем все в цепочке было выполнено. В журнале появилась соответствующая запись о событии.

Да придет спаситель

И именно здесь «Шаман» действительно помог, потому что вручную настроить такие привязки правильно и предсказуемо — довольно сложная задача. Это абстрагирует сложность управления новыми машинами с массивными параметрами, раскладку в αυτούς сервисов через Docker контейнеры, настройку и регистрацию конечных точек этих сервисов в Orchestrator — обычно куча вещей, которые будут проблематичны для мозга любого разработчика, и, положа руку на сердце, не нужны. Вместо этого я вижу трезвый, минималистичный, но все же достаточно понятный интерфейс, который освобождает меня от необходимости заглядывать в бездны низкоуровневого администрирования.

Что если вам нужно сделать копию среды для тестирования второй версии? Вам ведь не нужно перестраивать весь пакет с нуля? Что, если вы немного измените его? Для подобных случаев Shaman предоставляет возможность создания шаблона конфигурации, который использует YAML для описания всего набора машин, сервисов и конечных точек. Если ваша команда сохраняет свой шаблон, создание нового экземпляра расширенного набора сервисов становится тривиальной задачей.

И коллеги, похоже, с этим согласны:

«Для меня лично деплатформация не представляет сложности. А поскольку мне иногда приходится делать более десяти тестовых запусков в день, а также разрабатывать совершенно новые приложения, я очень рад, что мне не нужно каждый раз вызывать кого-то из отдела инфраструктуры. У нас много приложений, и возможность разрабатывать их самостоятельно делает жизнь намного проще и быстрее, — говорит Роман Литвинов, разработчик ROR.

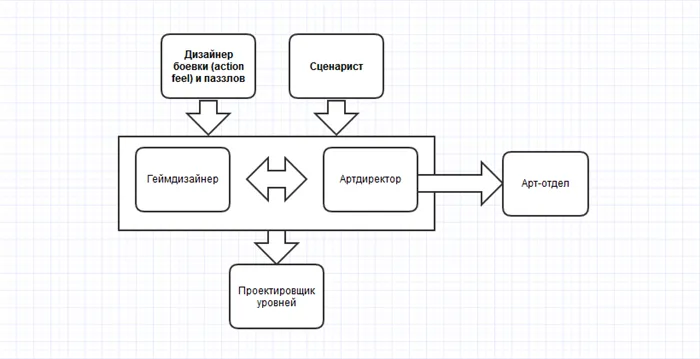

Схема связи «Шамана» с кодом

В настоящее время почти все наши репозитории GitHub создаются с помощью GitHub Actions, в результате чего образ Docker размещается в общем частном репозитории Docker. Этот рабочий процесс может быть запущен автоматически (push to the release branch) или вручную, если вы хотите попробовать некоторые немедленные исправления. Затем «Jackman» добавляет новое изображение и загружает его в сцену. Разве это не здорово?

И поскольку этот процесс находится более чем в руках разработчиков, у нас есть возможность упростить его. Я, например, все еще расстроен тем, что мне приходится сначала заходить на GitHub, чтобы увидеть статус сборки, а затем в «Шаман», чтобы нажать заветную зеленую кнопку для получения изображения. После небольшого расследования, проведенного коллегами по инфраструктуре, выяснилось, что последняя предоставляет API, ручку которого можно получить из Github Actions с адресом для размещения и идентификатором изображения для размещения. Это означает, что вы можете расшифровать код полностью автоматически!

Когда что то идёт не так…

Конечно, после развертывания кода необходимо убедиться, что он ведет себя так, как задумано. Опять же, у нас немного меньше автоматизации, но, опять же, все под контролем. Для мониторинга мы используем Sentry, который предупреждает нас о новых отдельных ошибках, а также об изменениях в общем фоне. Мы также используем приборные панели с метриками. С другой стороны, с помощью Shaman вы можете быстро и без особых усилий откатить назад баговую версию внешнего приложения, если возникли серьезные проблемы.

Мой ответ — да, если существует такая система, облегчающая вашу жизнь. Потому что ваша служба — это ваша крепость. И вы должны отвечать за это на всех этапах, включая этап запуска. Да, это требует больше знаний, но наш операционный отдел создал хорошую абстракцию, которая скрывает большинство низкоуровневых процессов.

С таким мышлением вы можете развертывать задачи, когда они готовы, вместо того чтобы объединять их в длинные версии, на тестирование которых уходит много времени. Больший контроль и меньшая вероятность ошибок.

И еще фактор времени: гораздо быстрее развернуть версию самостоятельно, чем поручить это специализированным инженерам. Но, конечно, с допущениями:

Службы появляются и исчезают, поэтому шаблон для пакета служб всегда должен быть актуальным, иначе создание новых тестовых сред превратится в утомительную задачу.

Следует помнить, что мы работаем с внутренним решением, со всеми вытекающими последствиями: оно может сломаться. Поэтому здесь нужно быть достаточно открытым и помогать своим коллегам решать проблему, а не спорить о решении.

Η υπηρεσία πληρωμών για παίκτες με βάση το Perm, Xsolla, ανακοίνωσε την είσοδό της στην κινεζική αγορά στις αρχές Μαΐου 2022. Η εταιρεία, γνωστή για το σκάνδαλο των απολύσεων εργαζομένων λόγω «αναποτελεσματικότητας» και «χαμηλής παραγωγικότητας» και τις αμφιλεγόμενες δηλώσεις του ιδρυτή της και νυν πρώην διευθύνοντος συμβούλου της, άνοιξε γραφείο στην κινεζική πρωτεύουσα, δήλωσε ο ιδρυτής της Αλεξάντερ Αγκαπίτοφ.

Η Xsolla θα έχει την έδρα της στο Λος Άντζελες από τον Μάιο του 2022. Η εταιρεία αναπτύσσει λύσεις για την απλοποιημένη αποδοχή πληρωμών από εκδότες, προγραμματιστές και διανομείς παιχνιδιών. Στους συνεργάτες περιλαμβάνονται η Twitch, η Epic Games και άλλοι. Σύμφωνα με την ιστοσελίδα της Xsolla, οι υπηρεσίες της λειτουργούν σε περισσότερες από 200 χώρες και σε 130 νομίσματα.

Существуют и другие решения, например, ZooKeeper и Consul от HashiCorp для ConfigMaps или Vault, Keywhiz и Confidant от HashiCorp для секретов. Они могут лучше соответствовать вашим потребностям.

4 часа, die(); и 11 514 чеков

Στα τέλη Απριλίου 2022, η Xsolla παρουσίασε μια beta έκδοση του εργαλείου NFT για προγραμματιστές παιχνιδιών. Το Checkout θα διαχειρίζεται τις πληρωμές εντός του παιχνιδιού που σχετίζονται με την αγορά μη ανταλλάξιμων μάρκων. Το εργαλείο βοηθά τους προγραμματιστές να ενσωματώσουν το NFT σε μηχανισμούς παιχνιδιών γρήγορα και με ασφάλεια. Οι παίκτες, με τη σειρά τους, θα μπορούν να πραγματοποιούν αγορές γρήγορα και εύκολα χρησιμοποιώντας την επιθυμητή επιλογή πληρωμής.

Στις 3 Φεβρουαρίου 2022, η Xsolla, μια παγκόσμια εταιρεία λύσεων νομισματοποίησης βιντεοπαιχνιδιών, ανακοίνωσε τον διορισμό του Konstantin Golubitsky ως διευθύνοντος συμβούλου. Διαβάστε περισσότερα εδώ.

Στις 18 Ιουνίου 2020, ανακοινώθηκε ότι η DMarket, μια πλατφόρμα εμπορίας αντικειμένων εντός παιχνιδιού και τεχνολογία νομισματοποίησης εντός παιχνιδιού για προγραμματιστές παιχνιδιών, δημιουργούς περιεχομένου, εμπορικά σήματα και παίκτες, συγκέντρωσε επενδύσεις ύψους 6,5 εκατομμυρίων δολαρίων από το ταμείο επιχειρηματικών κεφαλαίων Almaz Capital καθώς και από την Xsolla. Κάντε κλικ εδώ για περισσότερες πληροφορίες.

Η αστυνομία και η FSB πραγματοποίησαν έφοδο στο γραφείο της εταιρείας πληροφορικής Xsolla στο Περμ. Αυτό ανέφερε τον Φεβρουάριο του 2019 το διαδικτυακό περιοδικό Zvezda της Περμ. Η επιθεώρηση ξεκίνησε στις 9:30 π.μ. τοπική ώρα. Τα κινητά τηλέφωνα κατασχέθηκαν από τους υπαλλήλους της εταιρείας και απαγορεύτηκε η έξοδος από το κτίριο. Τα γραφεία της Xsolla στο Περμ βρίσκονται στη Λεωφόρο Κομσομόλσκι 12.

Ο ιδρυτής της Xsolla Alexander Agapitov εξήγησε τους πιθανούς λόγους για την επιθεώρηση. «Το Xsolla είναι καταχωρημένο στις ΗΠΑ. Όλες οι ηλεκτρονικές αγορές από ξένες εταιρείες υπόκεινται σε ΦΠΑ, ο οποίος είναι 20% το 2019. Αυτός είναι ο «φόρος Google». Έχουμε τεράστιο κύκλο εργασιών και το 20% είναι μεγάλο ποσό. Αυτό εξηγεί την παρουσία αξιωματικών της FSB. Αλλά έχουμε πληρώσει τα πάντα», ανέφερε ο ίδιος σύμφωνα με τη Zvezda.

Клонирование баз

Ο Agapitov πρόσθεσε ότι κατά τη διάρκεια της επιθεώρησης, οι λογιστές της εταιρείας παρείχαν στους διωκτικούς υπαλλήλους τα έγγραφα που ζητήθηκαν σε ξεχωριστό γραφείο.

QA-инженер

Εάν έχετε πειστεί ότι έχετε απενεργοποιήσει όλες τις συνδρομές Xsolla, αλλά εξακολουθούν να χρεώνονται χρήματα και η υπηρεσία εξυπηρέτησης πελατών δεν σας έχει βοηθήσει, η μόνη επιλογή για να λύσετε το πρόβλημα είναι να μπλοκάρετε την τραπεζική σας κάρτα και να την επανεκδώσετε.

Η Xsolla είναι μια μεγάλη εταιρεία που υπήρχε για κάποιο χρονικό διάστημα με την επωνυμία 2pay. Διαχειρίζεται οικονομικές συναλλαγές που σχετίζονται με παιχνίδια πολλαπλών παικτών και διάφορα είδη παιχνιδιών.

Stage-сервер

Η Xsolla έχει την έδρα της στο Λος Άντζελες των ΗΠΑ. Επιπλέον, η εταιρεία διαθέτει γραφείο αντιπροσωπείας στη Ρωσική Ομοσπονδία (πόλη Περμ).

Μεταξύ των συνεργατών της εταιρείας είναι η υπηρεσία ροής Twitch, το Steam και πολλοί άλλοι οργανισμοί που συνδέονται με τα παιχνίδια με τον έναν ή τον άλλο τρόπο.

Доверяй, но проверяй

Мы создали наш первый staging-сервер, на котором мы научились бросать любую ветку с любой базой для тестирования нового кода. Сценический сервер стал настолько популярным, что нам пришлось почти сразу же добавить еще: команда поддержки хотела сделать то же самое при работе с запросами клиентов, чтобы убедиться в наличии ошибки.

Когда спрос на серверы сцены превысил десять, poster-core-tools был расширен, чтобы включить возможность автоматического обеспечения. 40 серверов доступны для ручного тестирования и еще 10 — для автоматизированного. При необходимости мы можем добавить еще несколько десятков с помощью одной утилиты.

Теперь каждый разработчик, прошедший этап тестирования, получает право перейти на серверы Battle. Но так было не всегда.

В первые дни код передавался от основателей компании на серверы Battle. Пересмотры были разными: иногда код тщательно пересматривался, иногда — косо.

Когда тогдашний технический директор устал видеть мой код и мы научились разрабатывать его на Capistrano, все обзоры кода и право на неформальную разработку перешли ко мне. Так продолжалось около полутора лет, пока я не стал самым большим узким местом в ядре, и скорость предоставления функций клиентам начала падать из-за меня.

Это был первый урок: мы поняли, что технические лидеры не должны халтурить и что мы должны делегировать права на разработку и рецензирование другим. На тот момент я уже был техническим директором, поэтому нам пришлось немного ускорить процесс. Для ускорения процесса были созданы позиции технической поддержки между back-end и front-end разработчиками. Эти ребята взяли на себя задачи по обзору и разработке, что значительно продвинуло нас вперед.

Мы постепенно реорганизовали команды в кросс-функциональные группы, назначив в каждую из них двух бэкенд-инженеров и одного фронтенд-инженера, чтобы они могли просматривать и разрабатывать код друг друга. Поначалу все было хорошо, но со временем стало не по себе: трое из шести разработчиков занимали руководящие технические должности, отвечая в основном за рецензирование и разработку.

Такая система просуществовала около полутора лет, пока один бэкенд-технолог на трех бэкенд-разработчиков не остался в одной команде по разным причинам. Поскольку он тратил все свое время на анализ и разработку, он начал немного застревать.

Весной прошлого года мы приняли трудное, но в то время революционное решение: Мы упразднили должности технической поддержки и дали право уволиться всем, кто прошел трехмесячный испытательный срок. К счастью, в командах уже сложилась культура взаимной оценки, поэтому реструктуризация прошла гладко. Положительным моментом является то, что ответственность за код, который мы написали, была передана от технического редактора редактору кода.

Подведем итог

Теперь очевидно, что мы приняли правильное решение. К сожалению, сегодня проверки кода не такие жесткие, как раньше. И особенно это касается парней, которые одиноки в своих технических командах. Эта проблема решается гильдиями, но я думаю, что в ближайшие полгода процесс рассмотрения изменится для них в лучшую сторону.

Около трех месяцев назад на собрании разработчиков мне, генеральному директору и главе инженерного отдела было запрещено дедуплицировать код без рассмотрения соответствующей гильдией….. Поэтому мы живем, создав отдел с бирюзовой методологией.

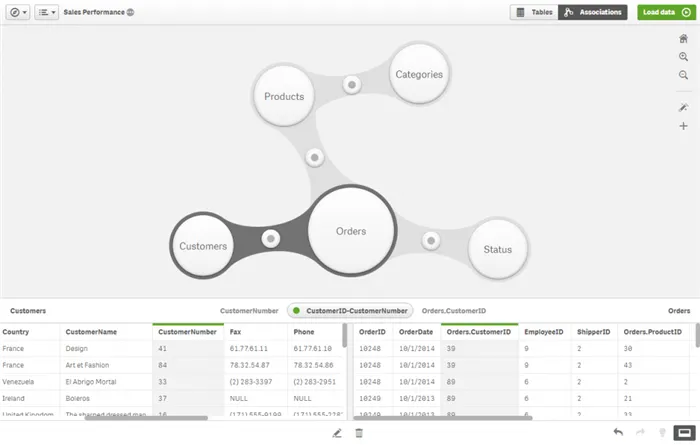

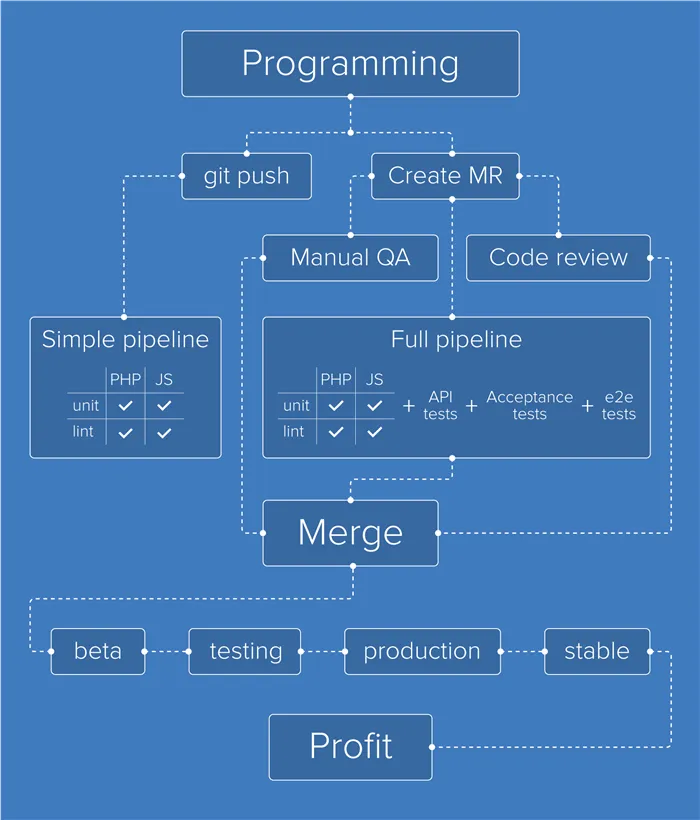

Сейчас мы используем GitLab (для хранения репозитория) и непрерывную интеграцию. Мы используем Deployer для непрерывной разработки, и все начинается с GitLab.

Каждый раз, когда разработчик помещает свой код в репозиторий, мы запускаем модульные тесты и проверяем стиль кода на JS и PHP.

После того, как ветка готова, разработчик размещает MR. На этом этапе расширенный конвейер вместе с развертыванием филиала направляется на серверы этапа, которые предназначены для автоматизированного тестирования. Тесты представляют собой тесты API, приемочные тесты в Codeception и тесты E2E в Selenium.

Порядок действий — на усмотрение разработчика: ждем ли мы автоматических тестов или нет, нам нужно передать ветку на проверку и, возможно, ручное тестирование. При ручном тестировании инженеры QA размещают код на серверах сцены и запускают там свои тестовые случаи.

Как только они проходят всевозможные тесты и проверки, GitLab принимает MR, и код автоматически распространяется среди клиентов в бета-ветке. На следующий день код переносится в тестирование, а затем в продакшн. Со следующего понедельника код перейдет из производственной версии в стабильную.

Настройка deployer’а

При необходимости разработчик может перевести код не в бета-версию, а в бета-фазу 2 / бета-фазу 3 / бета-фазу 4 и привлечь некоторых заинтересованных клиентов для тестирования функции в течение некоторого времени. Но потом она все равно перейдет в стадию бета-версии.

В прошлом, например, мы намеренно не писали тесты, а работали как можно больше над новыми возможностями системы, чтобы закрепиться на растущем рынке. В то время над тестированием работала только команда, ответственная за подачу данных о продажах в налоговые органы (здесь цена ошибок была очень высока и измерялась в штрафах для наших клиентов).

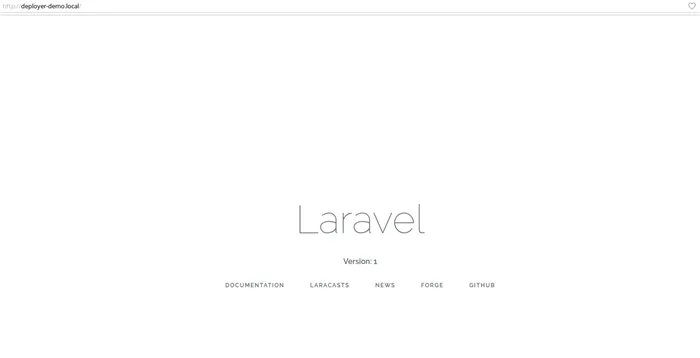

На нашем локальном компьютере мы устанавливаем Deployer:

В папке нашего демонстрационного проекта мы инициализируем конфигурацию deployer:

Сценарий создал файл конфигурации по умолчанию для нашего проекта — deploy.php. Приступим к настройке нашего проекта.

Разработчик создает новый каталог с кодом для каждого развертывания и хранит в нем определенное в конфигурации количество версий. Однако некоторые директории не должны меняться от версии к версии, например, в Laravel директория хранения, где хранятся журналы, загруженные пользовательские файлы и другие вещи. Нам нужно добавить эту папку в каталог shared_dirs, и для нее будет создана симлинк. То же самое относится к некоторым файлам, например, к конфигурационному файлу .env. Для файлов эта настройка называется shared_files.

Некоторые каталоги должны иметь доступ на запись, в этом случае они должны быть добавлены в writable_dirs:

Теперь дело за настройкой сервера, на котором мы хотим разместить код. Об этом говорится в разделе «Хост». Мы указываем IP-адрес сервера, имя пользователя и путь к директории проекта на сервере.

При такой конфигурации delployer использует стандартный SH-ключ и настройки агента. Однако возможна и более детальная конфигурация, подробнее см. в документации.

Для работы Laravel требуется конфигурационный файл .env. Чтобы избежать ручной загрузки этого файла при развертывании или внесении первого изменения, можно добавить задачу для загрузки файла. В корне нашего проекта создайте файл .env.production с настройками окружения для production (не забудьте добавить его в файл .gitignore, чтобы он не попал в ваш репозиторий). Этот файл загружается в общий каталог при загрузке, а поскольку он добавлен в каталог shared_files, для него создается символическая ссылка, чтобы он всегда был актуальным.

Деплоим!

Чтобы добавить эту задачу в процесс Deploc, нам нужно переопределить задачу Deploy — задачу, которая описывает действия Deploc в том порядке, в котором они выполняются. Для Laravel это выглядит следующим образом:

Обратите внимание, что artisan:migrate аннотирован, поскольку наш демонстрационный проект не использует базу данных. В результате наш deploy.php выглядит следующим образом:

Мы готовы к развертыванию. В корневом каталоге нашего проекта выполните простую команду:

Мы проверяем код, который мы записали на сервере:

Мы видим, что весь код доставлен, зависимости установлены и символические ссылки добавлены. Все в порядке. Осталось только настроить nginx. Используйте следующую минимальную конфигурацию:

Мы готовы к развертыванию. В корневом каталоге нашего проекта выполните простую команду:

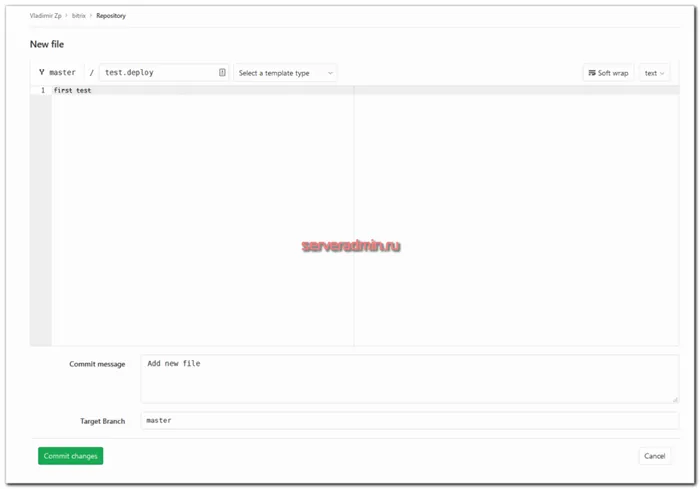

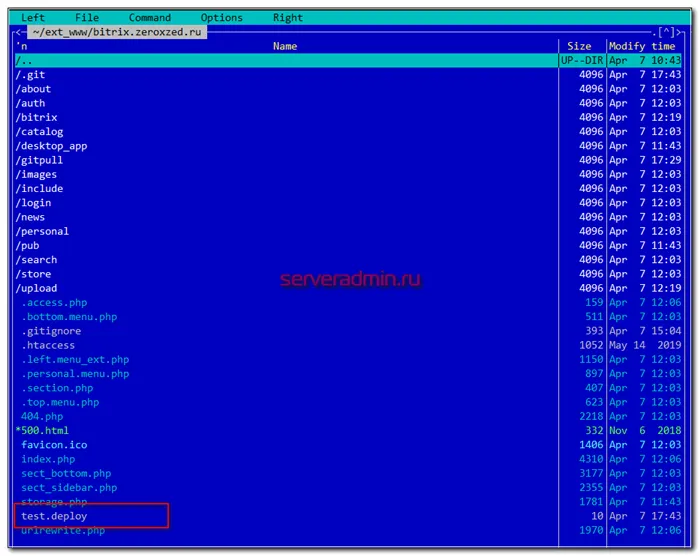

Проверка деплоя (deploy) bitrix

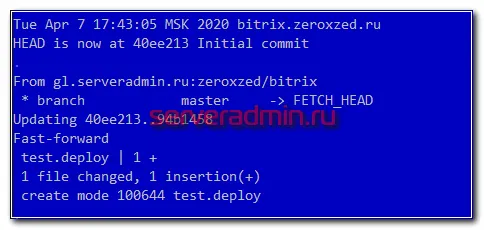

Теперь давайте выполним тестовую загрузку. Измените код, зафиксируйте его и протестируйте, чтобы убедиться, что он работает правильно.

Мы видим, что весь код доставлен, зависимости установлены, символические ссылки добавлены. Все в порядке. Осталось только настроить nginx. Используйте следующую минимальную конфигурацию:

Теперь давайте проверим, как все будет работать. Для этого можно либо клонировать репозиторий с исходниками, внести изменения, связать их и запустить в репозитории. Вы также можете просто добавить новый файл через веб-интерфейс Gitlab и сделать коммит.

Он автоматически появился после фиксации, которая вызвала вебхук в Gitlab, а затем все в цепочке было выполнено. В журнале появилась соответствующая запись о событии.

Вызовите сервер и найдите этот файл в корне сайта.

Он попадает сюда автоматически после фиксации, которая запустила веб-крючок в Gitlab. А затем все выполнялось по цепочке. Соответствующая запись о событии появляется в файле журнала.

Заключение

Просто проверьте, что ответ на запрос php-файла содержит соответствующий токен в заголовках. url gitpull/index.php должен вернуть ошибку.

В любом случае, при установке измените путь gitpull на свой собственный. Если у вас есть собственный сервер gitlab, вы можете ограничить доступ к нему на основе IP сервера, с которого приходит хук.

Вам не понравилась статья и вы хотите научить меня, как ею управлять? Пожалуйста, я рад учиться. Комментарии в вашем распоряжении. Расскажите мне, как правильно это сделать!

Надеюсь, это будет полезная статья о развитии Битрикс. Здесь так много нюансов и тонкостей. Разработчики, которые видят его впервые, не понимают, как с ним работать в принципе. Как организовать среду разработки и среду постановки? У Битрикса есть лицензия на копию сайта. Иногда происходит сбой при копировании сайта, а некоторые действия не выполняются при копировании.

Также проблемы возникают, когда сайт развернут для разработки на поддомене. Это не всегда возможно, поскольку существуют шаблоны, которые перенаправляют на основной домен. В результате поддомен постоянно перенаправляется на основной сайт. Ну и много других нюансов, которые нужно описывать отдельно, не входящих в рамки данной статьи.

У меня есть несколько черновиков различных представлений с использованием Gitlab и Teamcity, но у меня не хватает времени, чтобы превратить их в полноценные статьи. Тема узкая и не очень читабельная. На его написание уходит много времени, а процент откликов невелик. Возможно, в будущем я напишу еще что-нибудь на эту тему.

Теперь каждый разработчик, прошедший этап тестирования, получает право перейти на серверы Battle. Но так было не всегда.

Зачем это надо, если есть Docker и git и другие инструменты?

Если вы хотите научиться создавать и поддерживать высокодоступные и надежные системы, рекомендую онлайн-курс «Администратор Linux. Профессионал» на OTUS. Вы научитесь выполнять профессиональную настройку, управление процессами, безопасность, развертывание, настройку и обслуживание сети. Проверьте себя в ознакомительном тесте и узнайте подробности по ссылке.

Когда тогдашний технический директор устал смотреть мой код и мы научились разрабатывать его с помощью Capistrano, все права на просмотр кода и разработку были тихо переданы мне. Так продолжалось около полутора лет, пока я не стал самым большим узким местом в основной области, и скорость предоставления функций клиентам начала снижаться из-за меня.

Прелесть этого в том, что он почти полностью независим от внешней среды. Единственными внешними зависимостями являются Linux, bash и их стандартные инструменты и команды. Известно, что они обеспечивают очень стабильную совместимость между системами и поколениями. Это может сыграть решающую роль, если вам нужно развернуть проект на различных системах/серверах, если вы не можете обеспечить совместимую среду для более сложных пакетов (даже скрипты Python работают не везде!) и если у вас нет ресурсов (сил, желания), чтобы протянуть проект через постоянно развивающиеся (и не всегда заботящиеся об обратной совместимости) системы CI и DevOps.

Во-вторых, но не в последнюю очередь, не существует бэкдора для доступа к вашему репозиторию извне, поскольку система на серверах, на которые загружается проект, не использует Git.

Этапы внедрения автоматического деплоя сайтов и сервисов

И в-третьих, если вы просто не можете использовать что-то другое (клиент запретил, система не поддерживает, или другие экзотические ситуации).

- Мы являемся сторонниками перехода на Docker и переносим туда наши самые важные проекты, но старые проекты, которые живут в поддержке и не должны быть развернуты, остаются в этом инструменте, который был разработан и внедрен несколько лет назад и успешно работал все это время в сочетании со всеми инструментами и технологиями, упомянутыми в статье.

- Для полноценного использования системы необходимо выполнить следующие действия:

- Включите скрипты для создания и отображения пакета развертывания в репозитории проекта (0,5-10 минут).

Пошаговая инструкция по автоматизации развертывания веб-приложений в проекте

Настройте эти скрипты для работы с инфраструктурой вашего проекта (30-60 минут в первый раз, 10-15 минут во второй раз)

Подготовьте структуру каталогов на серверах для установки (полчаса в первый раз, несколько минут в последующие).

Шаг 1: Добавьте в проект скрипты для подготовки пакета установки и визуализации:

Создайте каталог CI в корне вашего проекта и загрузите в него два скрипта: deploy.sh и build-inst.sh с сайта https://github.com/tomsksoft-llc/ci-deploy-scripts-bash.git.

Вам не нравится название каталога CI? Используйте любое другое имя, просто запомните его для дальнейшей настройки.

Шаг 2. Адаптация сценариев к нашему проекту:

build-inst.sh — сценарий для сборки пакета установки, выполняется только на сервере сборки, не требуется на удаленных серверах.

В начале сценария есть одна строка:

Замените «my_project» на слово, подходящее для вашего проекта. Это имя будет использоваться как часть имени файла установочного пакета.

Чтобы создать пакет, достаточно поместить все нужные файлы в один файл и исключить ненужные, в данном случае каталог скриптов. Чтобы исключить все остальное, просто продолжайте писать — exclude=»bla…..» и так далее. Предупреждение. Некоторые версии tar имеют немного другой синтаксис, убедитесь, что он подходит для вашего сервера сборки. Этот скрипт будет выполняться только там и нигде больше. Вы можете переписать сценарий по своему усмотрению, включить его в процесс сборки или просто взять из него строку для получения файла — все, что вам нравится. Цель — получить архивный файл, который можно передать на удаленный сервер, распространить и запустить свой проект из файлов.

deploy.sh — выполняет все функции, упомянутые в начале статьи, работает на удаленных серверах.

Верхняя часть файла, константы, определяют его:

Здесь вы должны указать имя пользователя, который будет входить на удаленные серверы с вашим CI через ssh.

Вместо mygroupname вы указываете имя группы, в которую будет загружен каталог. Вы можете изменить их, просто убедитесь, что они реальны, и скрипт будет проверять несоответствия во время разработки и аварийно завершать работу, если обнаружит их.

Все то же самое, кроме каталога, который уже есть в предыдущем. В этом каталоге хранятся версии вашего проекта. Обычно все должно быть таким же, как и в предыдущем каталоге, но только для случая….. Кстати, это называется Turns. Если вы хотите изменить это имя, измените его в предыдущей строке:

и убедитесь, что имя совпадает с реальным именем при инициализации файловой системы на сервере.

Это имя и разрешение файла символической ссылки, который указывает на текущую рабочую версию. Вы должны использовать имя этой символической ссылки как «doc_root» при настройке веб-сервера. Здесь вы также указываете имя группы, к которой должен принадлежать файл, и при необходимости изменяете имя и разрешения.