Это дополнение для Firefox с десятками функций извлечения данных. Этот инструмент может автоматически искать на страницах и сохранять извлеченную информацию в формате, удобном для пользователя. OutWit Hub предоставляет простой интерфейс для экспорта небольших или больших объемов данных по мере необходимости.

Автоматизированный парсинг сайтов

Инструменты веб-скрейпинга предназначены для извлечения любой открытой информации с веб-сайтов. Эти ресурсы незаменимы, когда вам нужно быстро хранить и разделять данные из Интернета в структурированном формате. Веб-аналитика — это новый метод ввода данных, который не требует набора или вставки данных.

Этот тип программного обеспечения осуществляет поиск информации под контролем пользователя или автоматически, выбирает новые или обновленные данные и сохраняет их так, чтобы пользователь мог быстро получить к ним доступ. Analytics может использоваться, например, для сбора информации о товарах и их ценах с сайта Amazon. В следующем разделе представлены области применения онлайн-инструментов для добычи данных и десять лучших сервисов, которые можно использовать для сбора информации без написания специального программного кода. Инструменты анализа могут использоваться для разных целей и в разных сценариях. Давайте рассмотрим наиболее распространенные варианты использования, которые могут быть вам полезны.

Что такое парсинг сайтов

Веб-аналитика — это метод сбора данных с веб-сайтов. Он преобразует неструктурированную информацию в структурированные данные, которые можно использовать для анализа (например, значения или даже сорта).

Для людей, которые ничего не знают о программировании, может быть сложно написать свой собственный анализатор. В нашей команде над анализатором работают три (!) программиста, и работы еще очень много. К счастью, существуют инструменты, которые подходят как для программистов, так и для абсолютных новичков. Вот список 30 самых популярных инструментов для веб-аналитики, от библиотек с открытым исходным кодом, расширений для браузеров до настольного программного обеспечения.

Важно отметить, что все проанализированные нами популярные сайты в России (например, DNS, Ашан и т.д.) очень не любят этот процесс и всячески ему сопротивляются. Это может усложнить использование готовых конструкторов визуальной аналитики, перечисленных ниже. Кроме того, все перечисленные ниже решения имеют англоязычный интерфейс и документацию.

Зачем нужен парсинг

Инструменты веб-скрейпинга предназначены для извлечения и сбора информации из открытых источников на веб-сайтах. Эти ресурсы незаменимы, когда необходимо быстро получить и сохранить данные из Интернета в структурированном формате. Веб-аналитика — новый метод ввода данных

- Сбор данных для исследования рынка. Веб-сервисы извлечения данных помогут следить за ситуацией в том направлении, куда будет стремиться компания или отрасль в следующие шесть месяцев, обеспечивая мощный фундамент для исследования рынка. Программное обеспечение парсинга способно получать данные от множества провайдеров, специализирующихся на аналитике данных и у фирм по исследованию рынка, и затем сводить эту информацию в одно место для референции и анализа.

- Извлечение контактной информации

- Решения по загрузке с StackOverflow

- Поиск работы или сотрудников

- Отслеживание цен в разных магазинах В обзор ниже не попал Российский сервис парсинга сайтов и последующего мониторинга цен XMLDATAFEED, который разработан в Санкт-Петербурге и в основном ориентирован на сбор цен с последующим анализом. Основная задача — создать систему поддержки принятия решений по управлению ценообразованием на основе открытых данных конкурентов. Из любопытного стоит выделить публикация данные по парсингу в реальном времени 🙂

С помощью инструментов анализа можно собрать и систематизировать такие данные, как почтовые адреса, контактная информация с различных веб-сайтов и социальных сетей. Это позволяет составлять четкие списки контактов и всю необходимую деловую информацию — данные о клиентах, поставщиках или производителях. С помощью инструментов аналитики веб-сайтов можно создавать автономные и складские решения, собирая данные с большого количества веб-ресурсов (включая StackOverflow). Таким образом, можно избежать зависимости от активного интернет-соединения, поскольку данные доступны независимо от наличия или отсутствия интернет-соединения. Для работодателя, активно ищущего кандидатов для своей компании, или для соискателя, ищущего конкретную работу, инструменты аналитики также незаменимы: с их помощью можно создавать выборки данных на основе различных фильтров и получать информацию эффективно и без рутинного ручного поиска. Такие услуги также полезны для тех, кто активно пользуется услугами интернет-магазинов, отслеживает цены на товары и ищет вещи в нескольких магазинах одновременно.

Парсинг данных: лучшие сервисы для веб-скрапинга

Часто веб-мастеру, маркетологу или SEO-специалисту необходимо извлечь данные с веб-сайтов и отобразить их в подходящем формате для дальнейшей обработки. В этой статье мы объясним, что такое соскабливание данных, и познакомим вас с семью сервисами веб-соскабливания, которые не требуют навыков программирования.

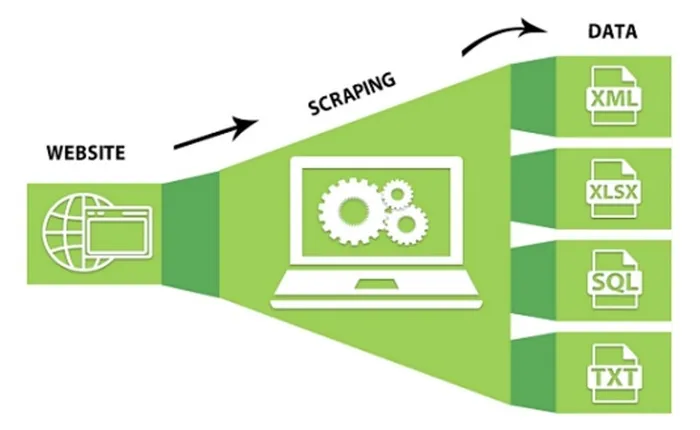

Веб-скрейпинг подразумевает извлечение данных с веб-сайта или приложения (в человекочитаемом формате) и сохранение их в таблице или файле.

Полезными данными могут быть:

- каталог товаров;

- изображения;

- видео;

- текстовый контент;

- открытые контактные данные — адреса электронной почты, телефоны и другая информация.

Это законный метод, но способ использования этих данных иногда может быть незаконным. Например, в октябре 2020 года Facebook подал иск в федеральный суд США против двух компаний, обвиненных в использовании двух вредоносных расширений для браузера Chrome. Эти расширения позволяли несанкционированно извлекать данные на Facebook, Instagram, Twitter, LinkedIn, YouTube и Amazon.

Оба расширения собирали публичные и непубличные данные пользователей. С другой стороны, компании продавали эти данные, которые затем использовались для маркетинговой информации — это незаконно.

Как используют полученные данные

Веб-скрейпинг/декомпозиция имеет очень широкий спектр применения. Например:

1. Отслеживание цен

Собирая информацию о товарах и ценах на них, например, на Amazon или других платформах, вы можете корректировать цены, чтобы опережать конкурентов.

2. Рыночная и конкурентная разведка

Если вы хотите выйти на новый рынок, сначала нужно оценить свои возможности, и только сбор и анализ данных поможет вам принять обоснованное решение.

3. Модернизация сайтов

Когда компании переносят свои старые веб-сайты на современные платформы, они используют скраппинг веб-сайтов для быстрой и простой загрузки данных.

4. Мониторинг новостей

Скраппинг новостных сайтов и блогов отслеживает интересующие вас темы и экономит ваше время.

5. Анализ эффективности контента

Блоггеры и создатели контента используют скраппинг для извлечения статистики о своих постах, видео и твитах в электронную таблицу. Например, в этом видео автор статьи берет данные из своего профиля на сайте Mediu

Сервисы для веб-скрапинга

Цена: Бесплатно для базовых задач, но есть и платные пакеты: $75 в месяц за Standard и $209 за Professional.

Особенности:

1. Octoparse

Сервис ScrapingBee Api использует «браузер без логов» и переключение прокси. Он также имеет API для получения результатов поиска Google.

Headless Browser — это инструмент разработки для тестирования кода, контроля качества и согласованности макета.

Цена: бесплатно до 1 000 вызовов API, после этого необходимо выбрать платный пакет от $29/месяц.

- Работает на всех сайтах: с бесконечным скроллом, пагинацией, авторизацией, выпадающими меню и так далее.

- Сохраняет данные в Excel, CSV, JSON, API.

- Данные хранятся в облаке.

- Скрапинг по расписанию или в реальном времени.

- Автоматическая смена IP для обхода блокировок.

- Блокировка рекламы для ускорения загрузки и уменьшения количества HTTP запросов.

- Можно использовать XPath и регулярные выражения.

- Поддержка Windows и macOS.

2. ScrapingBee

Особенности:

ScrapingBot предлагает несколько API: API для необработанного HTML, API для сайтов розничной торговли, API для соскабливания сайтов недвижимости.

Цена: бесплатный план на 100 единиц и платные планы: $47/месяц для фрилансеров, $120/месяц для стартапов и $361/месяц для бизнеса.

Особенности:

- Рендеринг JS.

- Ротация прокси.

- Можно использовать с Google Sheets и браузером Chrome.

3. ScrapingBot

Scrapestack — это REST API для соскабливания веб-сайтов в режиме реального времени. Он позволяет собирать данные с веб-сайтов за миллионы секунд, используя миллионы прокси-серверов и обходя капчи.

Цена: бесплатный план до 1 000 запросов и платные планы от $19,99 в месяц.

Особенности:

- Рендеринг JS (безголовый Chrome).

- Качественный прокси.

- До 20 одновременных запросов.

- Геотэги.

- Аддон Prestashop, интегрирующийся на ваш сайт для мониторинга цен конкурентов.

4. Scrapestack

API Scraper работает с прокси-серверами, браузерами и капчами. Интеграция проста: просто отправьте GET-запрос к API с ключом API и URL.

Цена: 1000 вызовов API бесплатно, хобби $29/месяц, стартап $99/месяц.

Особенности:

- Одновременные API запросы.

- Рендеринг JS.

- Шифрование HTTPS.

- Более 100 геолокаций.

5. Scraper API

Прежде чем разбирать (собирать) что-либо со страницы, необходимо знать, где это находится и в какой кодировке. Мы знаем, что все статьи Coda создаются по одному и тому же шаблону, поэтому нам достаточно посмотреть, как структурирована одна из них, чтобы понять их все.

Мы изучаем исходный код каждой из наших статей. Нас интересуют две вещи — кодировка страницы и тег. Мы должны убедиться, что этот тег содержит заголовок.

Особенности:

- Рендеринг JS.

- Геотэги.

- Пул мобильных прокси для скрапинга цен, результатов поиска, мониторинга соцсетей и так далее.

Изучаем исходный код страницы

Теперь прокрутите исходный код вниз и найдите тег, который отвечает за заголовок страницы. Давайте убедимся, что он есть и что возразить нечего:

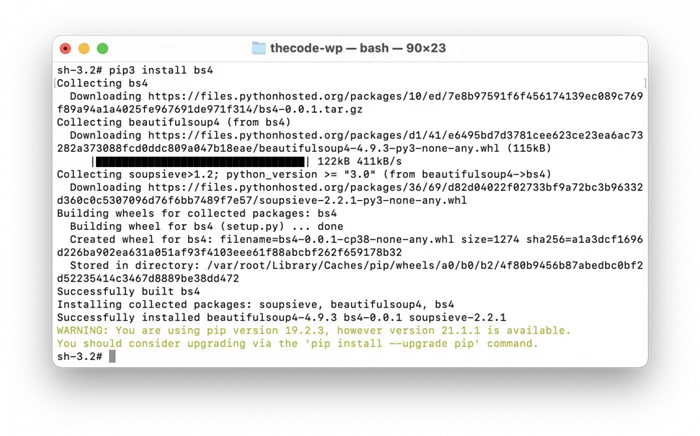

Нам нужны две библиотеки в проекте: urllib и BeautifulSoup.

Первый отвечает за доступ к страницам по их адресу, и оттуда нам просто нужен urlopen().read — он отправляет по заданному адресу и получает весь исходный код страницы.

Вторая библиотека является частью большой библиотеки bs4 — она уже содержит все команды для разбора исходного кода HTML и разбора тегов. Чтобы установить bs4, запустите терминал и введите:

Библиотеки для работы

pip3 install bs4

Сначала включите все библиотеки:

# включить urlopen из urllib.request import urlopen

# Подключите библиотеку BeautifulSoup из

Пишем код

# открываем текстовый файл для добавления заголовков file = open(«zag.txt», «a») # перебираем все адреса в списке for x in url: # получить исходный код следующей страницы в списке htmll_code = str(urlopen(x).read(),’utf-8′) # отправить исходный код страницы в библиотеку en soup = BeautifulSoup(htmll_code, «html. parser») # найти заголовок методом find() s = soup.find(‘title’).text # print(s) # сохранить заголовок в файл и поставить курсор на новую строку file.write(s + ‘

‘) # закрыть file.close()

Запустите его и посмотрите результат:

# connect urlopen from urllib.request import urlopen # connect library BeautifulSout from bs4 import BeautifulSoup url = «https://thecode.media/is-not-defined-jquery/», «https://thecode.media/arduino-projects-2/», «https://thecode.media/10-raspberry/», «https://thecode.media/easy-css/», «https://thecode.media/to-be-front/», «https://thecode.media/cryptex/», «https://thecode.media/ali-coders/», «https://thecode.media/po-glandy/», «https://thecode.media/megaexcel/», «https://thecode. media/chat-bot-generators/», «https://thecode. media/wifi/», «https://thecode.media/andri-oxa/», «https://thecode.media/free-hosting/», «https://thecode.media/hotwheels/», «https://thecode.media/do-not-disturb/», «https://thecode.media/dyno-ai/», «https://thecode.media/snake-ai/», «https://thecode.media/leet/», «https://thecode.media/ninja/», «https://thecode.media/supergirl/», «https://thecode.media/vpn/», «https://thecode.media/what-is-wordpress/», «https://thecode.media/hardware/», «https://thecode.media/division/», «https://thecode. media/nuggets/», «https://thecode. media/binary-notation/», «https://thecode.media/bootstrap/», «https://thecode.media/chat-bot/», «https://thecode.media/myadblock3000/», «https://thecode.media/trello/», «https://thecode.media/python-time/», «https://thecode.media/editor/», «https://thecode.media/timer/», «https://thecode.media/intro-bootstrap/», «https://thecode.media/php-form/», «https://thecode.media/hr-quiz/», «https://thecode.media/c-sharp/», «https://thecode.media/showtime/», «https://thecode.media/uchtel-rasskazhi/», «https://thecode. media/sshhh/», «https://thecode.media/marry-me-python/», «https://thecode.media/haters-gonna-code/», «https://thecode.media/speed-css/», «https://thecode.media/fired/», «https://thecode.media/zabuhal/», «https://thecode.media/est-tri-shkatulki/», «https://thecode.media/milk-that/», «https://thecode.media/binary-mouse/», «https://thecode.media/bowling/», «https://thecode.media/dealership/», «https://thecode.media/best-seller/», «https://thecode.media/hr/», «https://thecode.media/no-comments/», «https://thecode.media/drakoni-yajca/»,

Существуют специализированные аналитики для организаторов общего рынка (ОКУ), установленные на местах производителей товаров (например, одежды). И каждый может воспользоваться анализатором прямо на сайте и получить доступ ко всему ассортименту.

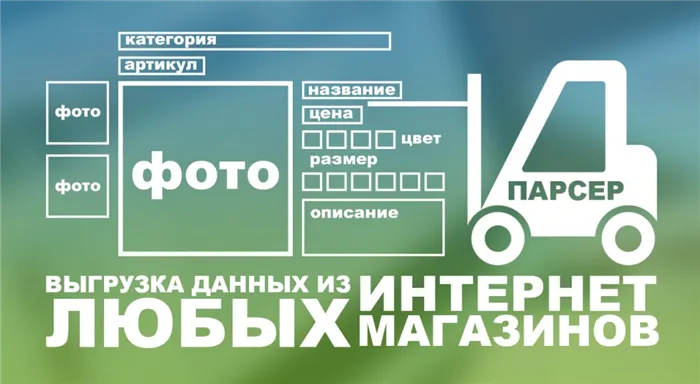

Эти службы собирают названия товаров, их описания, цены, изображения и другие данные с веб-сайтов спонсоров. Затем они загружают их в файл или непосредственно на ваш сайт. Это значительно ускоряет заполнение сайта и экономит вам много времени, которое в противном случае пришлось бы заполнять вручную.Такие анализаторы могут автоматически добавлять собственную наценку (например, если вы анализируете данные с сайта поставщика с оптовыми ценами). Вы также можете настроить программу на автоматический сбор или обновление данных.

Примеры таких анализаторов:

Виды парсеров по сферам применения

Для организаторов СП (совместных покупок)

Отдельная категория парсеров - это узконаправленные или многофункциональные программы, разработанные специально для решения задач SEO-специалистов. Такие парсеры предназначены для упрощения сложного анализа оптимизации веб-сайта. Вы можете использовать их:

Давайте рассмотрим некоторые распространенные анализаторы и изучим их основные характеристики и функции.

- интуитивно понятный интерфейс;

- возможность выгружать отдельные товары, разделы или весь каталог;

- можно выгружать данные в удобном формате. Например, в Облачном парсере доступно большое количество форматов выгрузки, кроме стандартных XLSX и CSV: адаптированный прайс для Tiu.ru, выгрузка для Яндекс.Маркета и т. д.

Стоимость: Первые 500 запросов бесплатны. Стоимость следующих запросов зависит от количества: до 1000 - 0,04 рубля/запрос; от 10000 - 0,01 рубля.

Парсеры цен конкурентов

Возможности

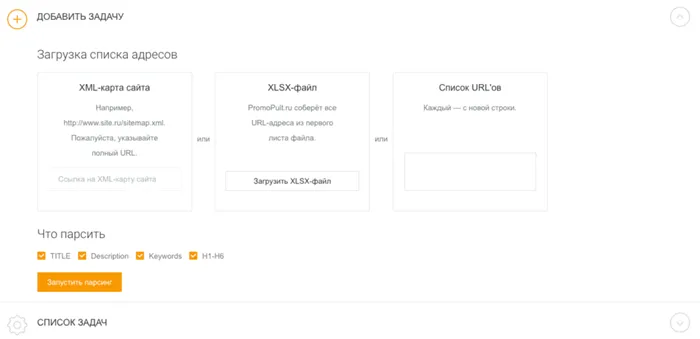

Meta Tags & Title Parser может захватывать заголовки h1-h6, а также содержание заголовка, описания и ключевых слов ваших собственных или сторонних сайтов.

Парсеры для быстрого наполнения сайтов

Этот инструмент полезен для оптимизации собственного сайта. Он может быть использован для обнаружения:

Анализатор также полезен для анализа SEO ваших конкурентов. Вы можете проанализировать, под какие ключевые слова конкуренты оптимизируют свои страницы, что они пишут в заголовке и описании и как оформляют заголовки.

Услуга работает "в облаке". Чтобы начать работу, необходимо добавить список URL-адресов и указать данные, которые вы хотите разделить. URL-адреса можно добавить вручную, или загрузить таблицу XLSX со списком адресов страниц, или добавить ссылку на карту сайта (sitemap.xml).

Парсеры для SEO-специалистов

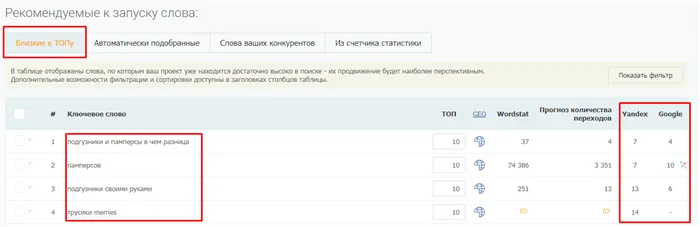

Анализатор метатегов и заголовков - не единственный инструмент анализа в системе PromoPult. В разделе SEO системы можно добавить ключевые слова, по которым добавленный в систему сайт находится на первых 50 позициях в Yandex/Google.

- анализировать содержимое robots.txt и sitemap.xml;

- проверять наличие title и description на страницах сайта, анализировать их длину, собирать заголовки всех уровней (h1-h6);

- проверять коды ответа страниц;

- собирать и визуализировать структуру сайта;

- проверять наличие описаний изображений (атрибут alt);

- анализировать внутреннюю перелинковку и внешние ссылки;

- находить неработающие ссылки;

- и многое другое.

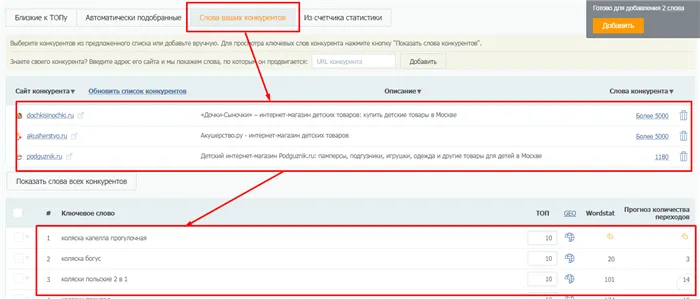

Здесь вы также можете избавиться от ключевых слов ваших конкурентов (до 10 URL за раз) с помощью вкладки "Ключевые слова ваших конкурентов".

Парсер метатегов и заголовков PromoPult

Подробнее о работе с анализом ключевых слов читайте в разделе SEO PromoPult здесь.

Стоимость: от $19 в месяц, есть 14-дневный пробный период.

Аналитик по комплексному анализу объектов. С помощью Netpeak Spider вы можете:

Краткий контрольный список, который поможет вам выбрать наиболее подходящий инструмент или услугу.

- страницы с пустыми метатегами;

- неинформативные заголовки или заголовки с ошибками;

- дубли метатегов и т.д.

Для крупных проектов, где необходимо анализировать большие объемы данных.

Основная проблема аналитика заключается в том, что сайт обнаруживает признаки нетипичного поведения и блокирует доступ. Пользователи не открывают тысячи страниц в течение нескольких минут. Поэтому задача аналитика состоит в том, чтобы притвориться обычным пользователем. Одним из шагов является использование эмуляторов пользовательских инструментов. Они отправляют HTTP-запросы на сервер под заголовком user agent, т.е. как обычный пользователь.

Еще один способ защиты - встроенный фрагмент JavaScript. Браузер выполнит сниппет успешно, но код HTML-страницы будет нечитаемым. Платформа node.js, которая позволяет запускать JS вне браузера, решает эту проблему.

Другой вариант - использовать "безголовый" браузер. Это программа, которая копирует функции обычного браузера, но не имеет графического интерфейса пользователя. Он управляется программным обеспечением и может работать в фоновом режиме.

В случае большого количества запросов с одного IP-адреса может потребоваться проверка с помощью капчи. Некоторые из них можно расшифровать с помощью визуального распознавания символов, но лучше сменить IP. Для этого используются прокси-серверы, которые запрашивают информацию с разных адресов.

Netpeak Spider

XPath - это язык запросов для доступа к частям XML-документа, который используется для поиска элементов с определенными атрибутами. Он используется для реализации навигации в DOM (Document Object Model) - интерфейсе программирования, который содержит информацию о структуре веб-сайта, HTML и XML документов.

Расширения для браузеров

- провести технический аудит сайта (обнаружить битые ссылки, проверить коды ответа страниц, найти дубли и т.д.). Парсер позволяет находить более 80 ключевых ошибок внутренней оптимизации;

- проанализировать основные SEO-параметры (файл robots.txt, проанализировать структуру сайта, проверить редиректы);

- парсить данные с сайтов с помощью регулярных выражений, XPath-запросов и других методов;

- также Netpeak Spider может импортировать данные из Google Аналитики, Яндекс.Метрики и Google Search Console.

Чек-лист по выбору парсера

Веб-приложения используются для решения простых задач. Они есть в каждом браузере. Они полезны для анализа небольших объемов данных (до нескольких страниц).

- Четко определите, для каких задач вам нужен парсер: анализ SEO конкурентов или мониторинг цен, сбор данных для наполнения каталога, съем позиций и т.д.

- Определите, какой объем данных и в каком виде нужно получать.

- Определите, как часто вам нужно собирать данные: единоразово или с определенной периодичностью (раз в день/неделю/месяц).

- Выберите несколько инструментов, которые подходят для решения ваших задач. Попробуйте демо-версии. Узнайте, предоставляется ли техническая поддержка (желательно даже протестировать ее — задать парочку вопросов и посмотреть, как быстро вы получите ответ и насколько он будет исчерпывающим).

- Выберите наиболее подходящий сервис по соотношению цена/качество.

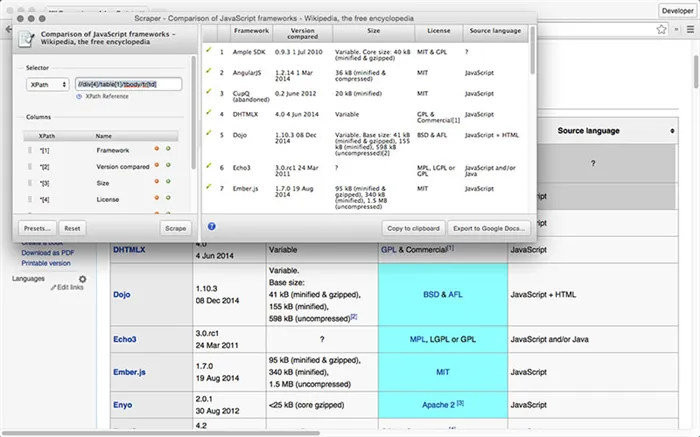

Этот инструмент используется для извлечения данных из таблиц или информации о страницах в форматах XLS, CSV и TSV. Платный доступ предлагает новые функции. Например, API и анонимный IP.

Стоимость: Бесплатно при объеме до 500 страниц.

Как противодействуют парсингу

Расширение предназначено для импорта данных с веб-сайтов. Он позволяет нажать на элемент страницы и выбрать все элементы данного типа на сайте.

Scraper.AI имеет функцию регулярного мониторинга изменений на сайте. Собранная информация экспортируется в форматах JSON, CSV и XLSX.

Стоимость: бесплатно в течение первых 3 месяцев, тарифы варьируются от $49 до $249 в месяц.

Облачные сервисы

По сравнению с расширениями, эти планы имеют больше возможностей. Работа выполняется в облаке через веб-интерфейс или API, и только результаты хранятся на вашем компьютере.

Эта услуга используется для анализа веб-сайтов с высоким уровнем безопасности. Его использование требует навыков программирования.

Программа итерирует неудачные запросы и самостоятельно обрабатывает капчи. Приложение также способно отображать данные, требующие использования javascript. API Scraper работает с Python, Ruby и PHP.

Как обойти защиту

Стоимость: 1 тыс. бесплатных API-запросов, пакеты от $29 до $249 в месяц.

Он использует алгоритмы ML и компьютерное зрение для анализа, а также работает с API и может автоматически соскабливать типы URL. Diffbot регулярно анализирует веб-страницы и сохраняет результаты. Он создает самый большой граф знаний - связывает факты о созданных продуктах, новых событиях и результатах отчетов. Подробнее о Diffbot можно узнать здесь.

Стоимость: бесплатно в течение первых 14 дней, тарифные планы Start и Plus стоят $299 и $899 в месяц.

Настольные приложения

Большинство настольных аналитических программ работают под Windows, но их можно запускать и на виртуальных машинах macOS. Существуют также кроссплатформенные решения.

Программы для парсинга

Настольные анализаторы могут быть более эффективными, чем облачные. Недостатком является то, что они отнимают оперативную мощность компьютера.

Программное обеспечение позволяет интегрировать и визуализировать собранные данные с помощью системы Tableau BI. Он поддерживает графический интерфейс "укажи и щелкни" для обработки данных. ParseHub имеет функцию таймерного сбора наборов данных через определенный промежуток времени. Сервис работает с Windows, Mac и Linux. Он доступен в облачной и настольной версиях.

Стоимость: бесплатно для обработки до 200 страниц, стандартный и профессиональный планы стоят $149 и $499 в месяц.

Библиотеки для создания собственного синтаксического анализатора

Библиотека на Java для разбора и автоматизации запросов в формате JSON. Это формат для обмена данными в веб-приложениях, например, для передачи информации от сервера к клиенту и отображения ее на сайте. Jaunt работает как браузер без графического интерфейса, что ускоряет процесс. Jaunt выборочно обрабатывает HTTP-запросы и ответы, а также имеет доступ к DOM.

Стоимость: бесплатно

Библиотека с открытым исходным кодом для Python. Фреймворк используется для синтаксического анализа. Особенностью Scrapy является асинхронная обработка запросов: вы можете задать команду, не дожидаясь завершения предыдущей команды. Кроме того, последующие запросы выполняются, даже если при обработке одного из них произошла ошибка.